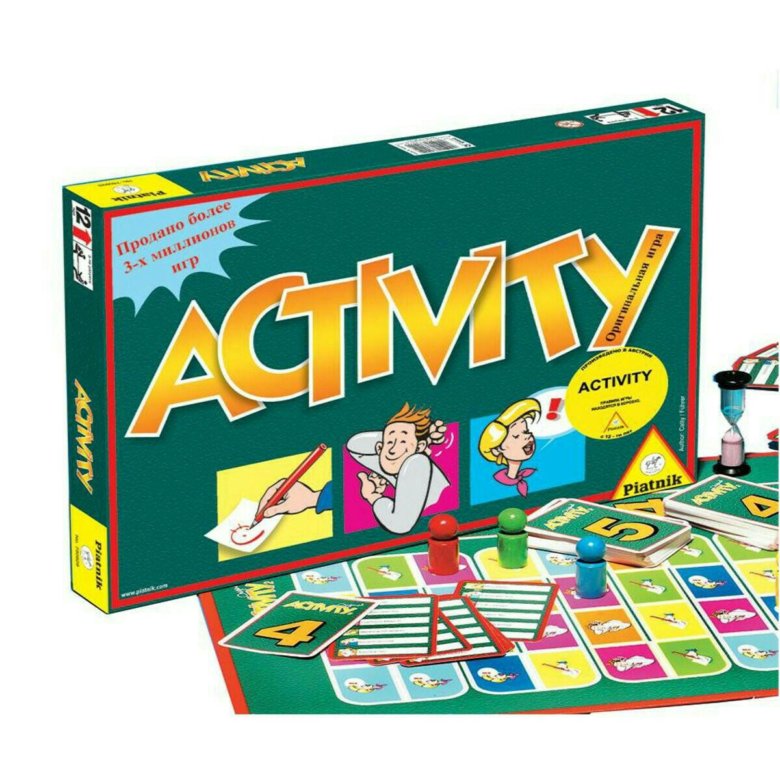

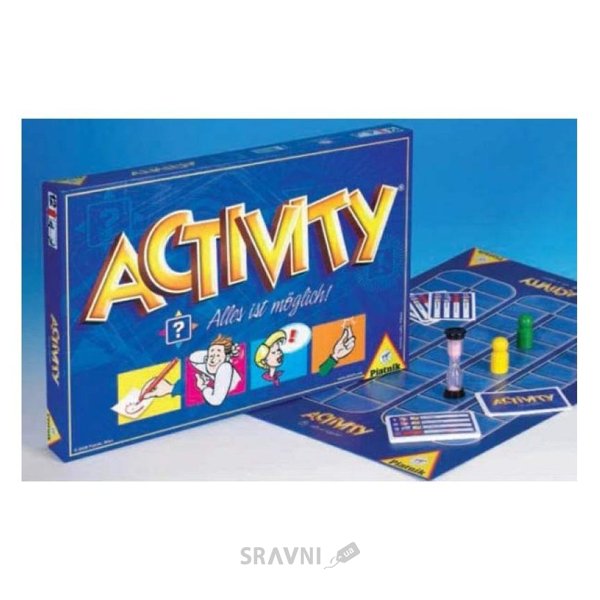

Настольная игра Activity/Активити Все возможно!

Вашему ребенку сложно выходить к доске, выступать перед людьми и вообще решительно заявляться в жизни? С настольной игрой «Activity/Активити Все возможно!» Вы поможете ему решить все эти проблемы! В игре Ваш ребенок будет неминуемо развиваться, станет более устойчивым и, в конце концов, в веселом и непринужденном взаимодействии с другими людьми сможет понять и принять себя.

Игра развивает коммуникативные навыки, умение различать невербальные проявления, художественные навыки, восприятие, креативность, раскованность, внимание, эмпатию, скорость реакции, умение быстро находить подходящее решение, нестандартно мыслить. Игра обогащает речь, увеличивает словарный запас, речь становится более выразительной. В игре ребенок будет учиться не боятся публики и спокойно проявлять себя.

Ход игры

Игроки

делятся на команды с равным количеством игроков в каждой команде.

Каждая команда должна состоять, по меньшей мере, из двух игроков.

Внимание: Каждая из команд должна приготовить бумагу и карандаш.

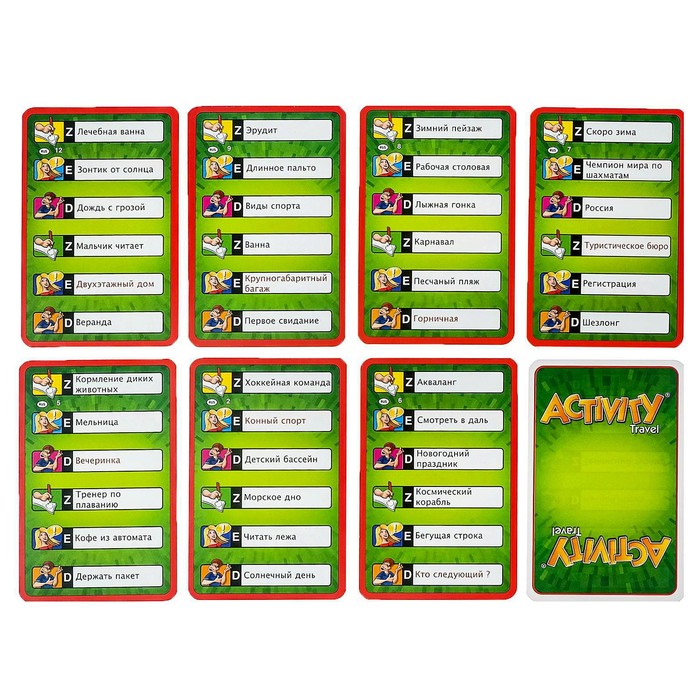

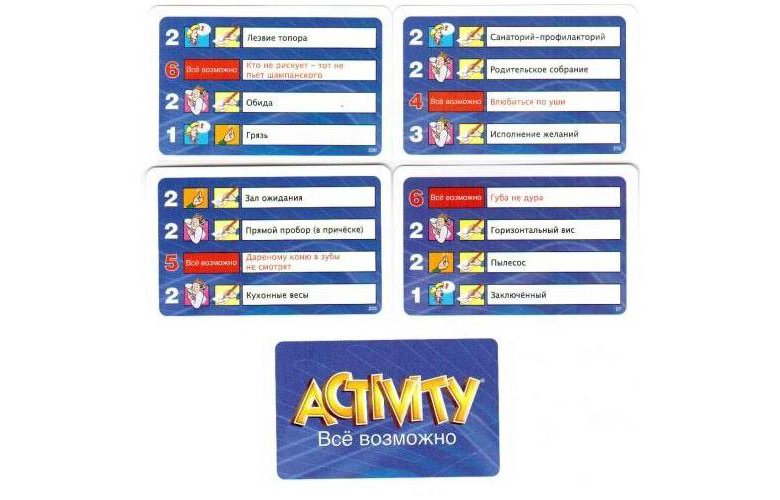

Цифры

рядом со словами на карте указывают на сложность той или иной карты.

Слова с цифрой 1 самые простые, с цифрами 2, 3, 4, 5 — более сложные, а с

цифрой 6, максимально сложные. Хотя всё это довольно субъективно.

Рисунки на картах имеют специальные символы (Пантомима, Объяснение,

Рисование и Звуки —

их не было в прошлых частях), которые показывают какими способами

должно быть объяснено слово. Команда, которая начинает игру, выбирает

одного из своих игроков, который будет «Исполнителем», и должен будет

объяснять в течение раунда слова, словосочетания, пословицы или

поговорки своей команде. Если на карточке указана поговорка, то

Исполнитель обязан предупредить об этом членов своей команды, которые

должны будут постараться максимально точно её назвать./pic3186165.jpg)

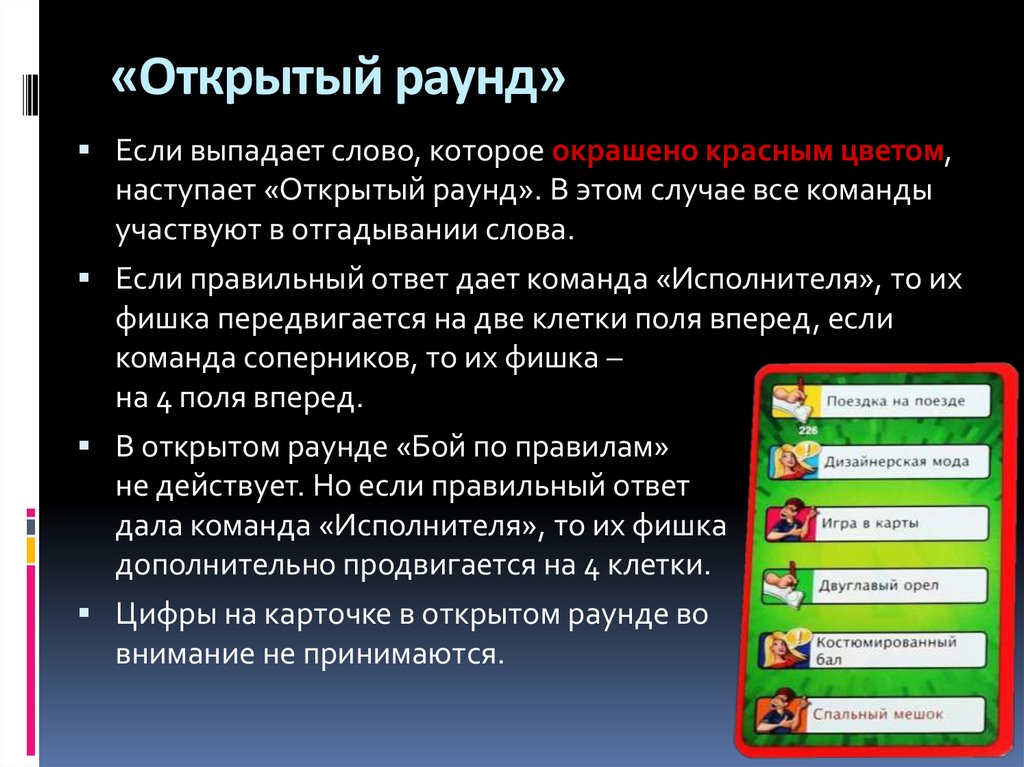

Игра начинается с первого игрока первой команды. Он берёт верхнюю карту из колоды таким образом, чтобы никто из игроков её не видел. Часы переворачиваются. У Исполнителя есть только 60 секунд, чтобы объяснить первое слово так, чтобы члены его команды смогли догадаться, что за слово на карточке.

В

случае если команда угадывает правильный ответ до истечения одной

минуты, фишка команды передвинется на количество шагов, обозначенных

цифрой на карте рядом с угаданным словом, то есть на 1, 2, 3, 4, 5 или 6

шагов. После правильного ответа команды Исполнителя, она получает

возможность второй раз участвовать в игре, Исполнитель в этом случае

использует ту же самую карту, описывая следующее слово, затем следующее

слово и т. д., до тех пор, пока все слова из этой карточки не будут

отгаданы, либо команда не сможет дать правильный ответ. Как только

команда ответила на все вопросы, помещённые на карточке, она может

выбрать нового Исполнителя.

Если команда не угадывает правильный ответ, тогда другие команды могут по очереди назвать по одному варианту решения, причем эти команды должны назвать свой ответ незамедлительно, не оставляя себе времени для обдумывания. Команда, которая дала правильный ответ первой, передвигает свою фишку на соответствующее количество полей вперед. Затем наступает очередь следующей команды в порядке очередности, исполнитель которой должен взять верхнюю карту из колоды таким образом, чтобы никто из игроков её не видел. Если по истечению минуты ваша команда не отгадала слово, то первая команда противника угадавшее слово получает ёё очки. Но не спешите расстраиваться, есть и обратная сторона медали, если вы отгадали слово в течении минуты, то вы можете за новую минуту отгадать следующее слово из той же карточки, и так до тех пор пока на карточке не останется слов.

Чем больше очков вы зарабатываете, тем ближе ваша команда к финишу. Победит тот, кто первым доберется до финальной черты.

Победит тот, кто первым доберется до финальной черты.

Цель игры

Точно и правильно объяснить членам своей команды все слова, используя различные формы общения (мимику, вербальные, графические описания и звуки), и первому привести свою команду к пересечению финишной линии.

Для кого эта игра

Возраст участников: от 12 лет

Количество участников: от 3 до 16 игроков

Игра развивает коммуникативные навыки, умение различать невербальные проявления, художественные навыки, восприятие, креативность, раскованность, внимание, эмпатию, скорость реакции, умение быстро находить подходящее решение, нестандартно мыслить. Игра обогащает речь, увеличивает словарный запас, речь становится более выразительной. В игре ребенок будет учиться не боятся публики и спокойно проявлять себя.

«Activity/Активити Все возможно!» это

увлекательная, веселая и разнообразная настольная игра, которая

подойдет как для семейного времяпрепровождения, так и для большой

компании.

Состав игры

Игровое поле;

4 фишки;

330 карт;

Песочные часы;

Правила игры.

Купить Настольную игру, Activity/Активити Все возможно!, Вы можете в магазине настольных и развивающих игр «Игры Почемучек»

Настольная игра активити правила в Орле: 500-товаров: бесплатная доставка [перейти]

Партнерская программаПомощь

Орел

Каталог

Каталог Товаров

Одежда и обувь

Одежда и обувь

Стройматериалы

Стройматериалы

Текстиль и кожа

Текстиль и кожа

Здоровье и красота

Здоровье и красота

Детские товары

Детские товары

Продукты и напитки

Продукты и напитки

Электротехника

Электротехника

Дом и сад

Дом и сад

Сельское хозяйство

Сельское хозяйство

Мебель и интерьер

Мебель и интерьер

Промышленность

Промышленность

Все категории

ВходИзбранное

Настольная игра активити правила

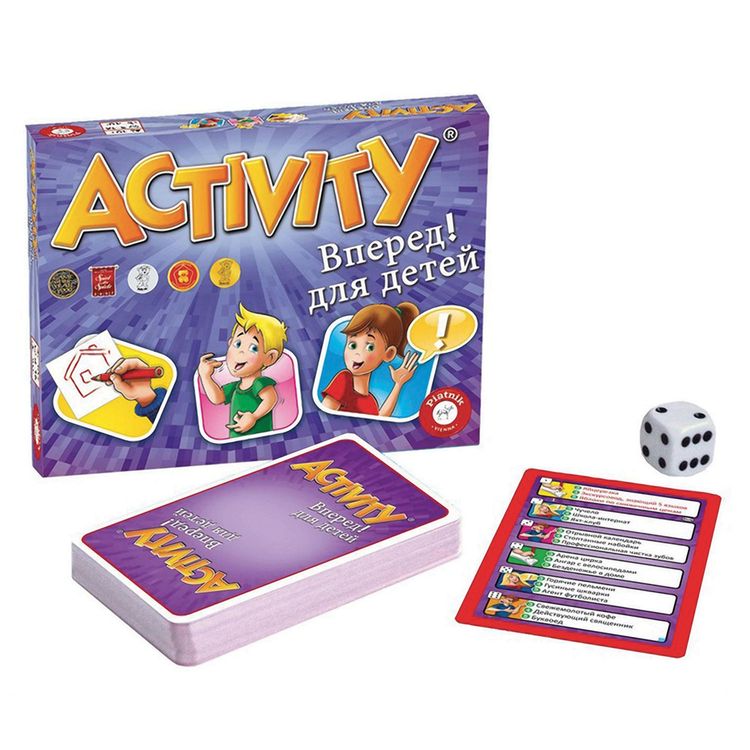

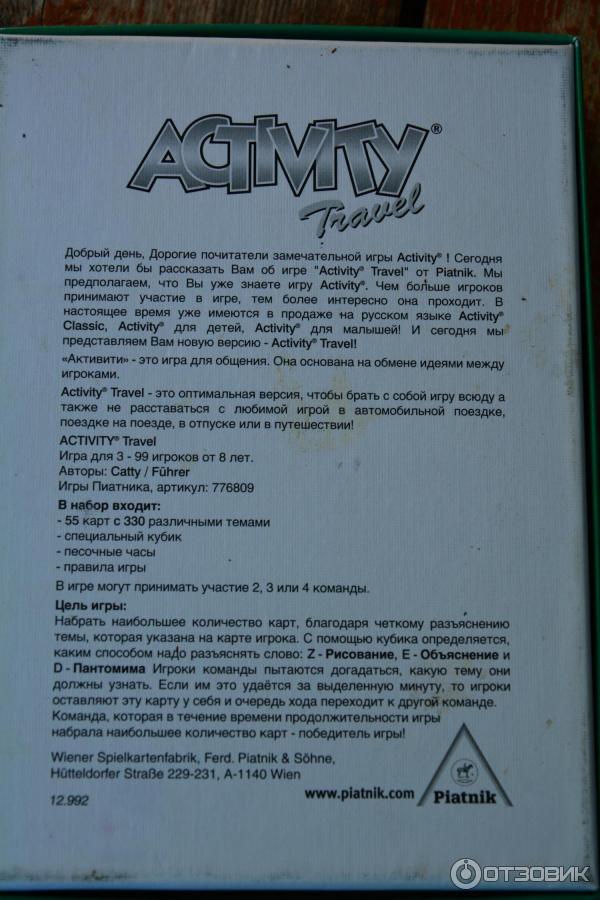

Настольная игра Activity, компактная версия, 1 шт. Piatnik Тип: настольная игра, Производитель:

Piatnik Тип: настольная игра, Производитель:

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра Активити для малышей Тип: настольная игра, Производитель: GAGA, Возраст: 3-5 лет,

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра «Activity для детей» Настолка Тип: настольная игра, Пол: для девочек, для

ПОДРОБНЕЕЕще цены и похожие товары

Настольная ролевая игра Pathfinder: Основная книга правил Вторая редакция Возраст: от 16 лет,

В МАГАЗИНЕще цены и похожие товары

Настольная ролевая игра Вампиры: Маскарад. Классические правила Игроки: 2-8, Время игры: 60-180

В МАГАЗИНЕще цены и похожие товары

Настольная игра Активити. Соло и Команды Возраст: от 12 лет, Игроки: 3-16, Время игры: 45-60 мин

В МАГАЗИНЕще цены и похожие товары

Настольная игра Активити для малышей (Activity for kids) Игроки: 3-16, Размеры: 345x40x220 мм,

В МАГАЗИНЕще цены и похожие товары

Настольная ролевая игра Фаза затмения. Вторая редакция: Правила быстрого старта Возраст: от 18 лет,

Вторая редакция: Правила быстрого старта Возраст: от 18 лет,

В МАГАЗИНЕще цены и похожие товары

Настольная игра Правила дорожного движения Время игры: 20-30 мин, Размеры: 245x55x245 мм, Возраст:

В МАГАЗИНЕще цены и похожие товары

Настольная ролевая игра Дюна: Приключения в Империи. Основная книга правил Возраст: от 18 лет,

В МАГАЗИНЕще цены и похожие товары

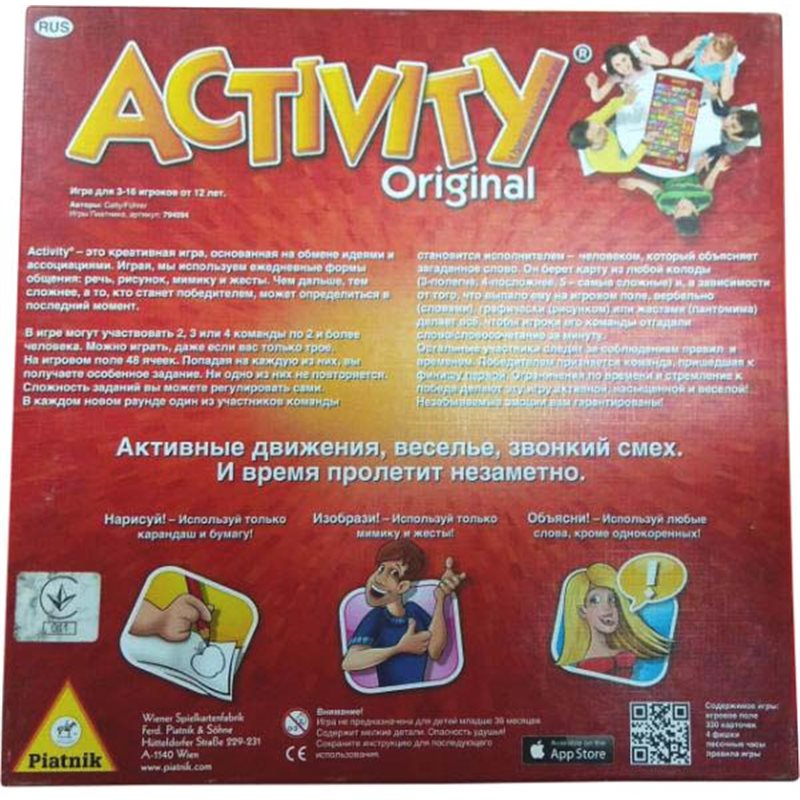

Настольная игра Activity Original

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра Свинтус: Правила этикета Время игры: 15-20 мин, Игроки: 2-10, Возраст: от 5 лет

В МАГАЗИНЕще цены и похожие товары

Правила дорожного движения Синий трактор Настольная игра-ходилка Ед-ца измерения: шт

В МАГАЗИНЕще цены и похожие товары

Игра настольная Русский стиль «Викторина. Правила дорожного движения», картонная коробка

Правила дорожного движения», картонная коробка

ПОДРОБНЕЕЕще цены и похожие товары

Игра настольная Звезда «Правила дорожного движения», картонная коробка

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра Свинтус. Правила этикета

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра Активити. Руки связаны Возраст: от 8 лет, Игроки: 3-8, Время игры: 45-60 мин

В МАГАЗИНЕще цены и похожие товары

Starfinder. Основная книга правил Время игры: 60-120 мин, Возраст: от 16 лет, Игроки: от 2

В МАГАЗИНЕще цены и похожие товары

Активити Original Юбилейное издание Тип: настольная игра, Жанр игры: для вечеринки, со словами,

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра Рыжий кот Правила дорожного движения ИН-0991 Тип: настольная игра, Производитель:

ПОДРОБНЕЕЕще цены и похожие товары

Настольная игра «Свинтус. Правила Этикета» Тип: настольная игра, Минимальное число игроков: 2

Правила Этикета» Тип: настольная игра, Минимальное число игроков: 2

ПОДРОБНЕЕЕще цены и похожие товары

2 страница из 18

Все, что вам нужно знать об активированных способностях в Magic

Последнее обновление: 27 сентября 2022 г.

Нарфи, Король-Предатель | Иллюстрация Дааркена

Magic может похвастаться широким набором различных карт, эффектов и способностей. Но если вы не углубитесь в правила, иногда детали того, как они работают, полностью теряются для вас.

Сегодня я расскажу об активируемых способностях. Что это такое, как они работают и как вы можете идентифицировать их на своих картах. Давайте просто прыгнем прямо в это!

Содержание

Что такое активируемая способность в магии?

Пожнешь то, что посеяно | Иллюстрация Синтии Шеппард

Готовы получить технические знания и использовать некоторые навыки пунктуации английского языка? Мы не так часто используем их в обычной речи, но вам нужно обратить внимание на двоеточие. Все активируемые способности в Magic отмечены двоеточием («:»). Это так просто.

Все активируемые способности в Magic отмечены двоеточием («:»). Это так просто.

Активируемые способности структурированы в виде списка затрат, которые вы должны заплатить, каждая из которых разделена запятой, за которой следует двоеточие, а затем эффект, который дает способность. Это выглядит примерно так:

[Стоимость 1], [Стоимость 2], [Стоимость 3] : [Эффект].

В качестве примера давайте посмотрим на недавнюю карту из Неоновая династия : Патруль Мотридер. У Patrol есть активируемая способность, которая гласит: « , Tap: коснитесь целевого существа». Его способность имеет две стоимости, указанные перед двоеточием (плата за три обычных и одну белую ману и поворот самого себя), а эффект, который вы получаете, заключается в повороте существа.

Какие вещи считаются активированными способностями?

Любой абзац на карте Magic, в котором есть двоеточие, является активируемой способностью. Так просто определить активируемую способность.

Способности верности planeswalker-ов также являются активируемыми способностями.

Странные примеры активированных способностей

В игре около 6500 карт, которые либо имеют активируемые способности, либо ссылаются на них. Среди этого огромного пула карт есть несколько действительно странных примеров.Хотя вы можете думать об активируемых способностях как о чем-то, что используют карты на поле боя, например, о повороте земель для получения маны или planeswalker-ах, использующих свои способности, на самом деле нет никаких причин, по которым мы не можем иметь способности, которые активируются из других зон. Канал и Цикл — примеры активируемых способностей, которые активируются в вашей руке. Есть также довольно много карт, которые активируются, когда они находятся на вашем кладбище, например, Нарфи, Король-предатель и Мощеный копейщик.

Безусловно, самая странная активируемая способность, которую я знаю, — это Lightning Storm, карта, которая раньше была условием победы в колодах Modern Ad Nauseam. Только небольшая горстка карт (всего пять) вообще ссылается на стек, не говоря уже об активируемой способности, которую можно использовать только находясь там.

Активируемые способности делают самые разные вещи. Хотя в основном их можно использовать только на поле боя, вы должны прочитать способность и найти подсказки о том, где ее следует использовать. Если карту нужно сбросить в качестве стоимости, то ее можно использовать только из руки. Если эффект возвращает его с кладбища, то конечно его можно использовать только с кладбища.

Когда можно использовать активируемые способности?

Активируемые способности обычно можно использовать в любое время, как если бы вы разыгрывали мгновенное заклинание. Это включает в себя, когда вы атакуете, во время вашего шага поддержки перед взятием карты на ход и даже в ход вашего противника.

Но есть некоторые исключения. Некоторые способности указывают время, когда вы можете их активировать, например, механика прогноза в Перьях мира или первая способность Вечного дракона.

Наиболее распространенное ограничение, которое вы увидите на картах, это «активировать только как волшебство», что означает, что вы можете активировать его только в одну из ваших собственных основных фаз, пока стек пуст, так же, как если бы вы разыгрывали заклинание волшебства. А еще есть самоочевидное «активировать только один раз за ход».

Можно ли активировать способность существа до того, как оно умрет?

Предполагая, что вы можете оплатить стоимость, вы можете полностью активировать способность существа до того, как оно умрет. Самое лучшее в существах, которые жертвуют собой в ущерб своей способности, заключается в том, что ремув очень плох против них, и они отлично блокируют болванов. Sakura-Tribe Elder — мой любимый пример этого, позволяя вам разыграть его и поглотить немного урона, прежде чем пожертвовать собой ради ценности.

Это также включает в себя другие виды активируемых способностей. Если у вашего существа есть способность поворота, но вы хотите заблокировать с его помощью, вы всегда можете просто заблокировать, пока оно не повернуто, а затем коснуться его, чтобы использовать его способность, прежде чем оно умрет в бою. То же самое происходит, если он предназначен для удаления. С тем же успехом вы могли бы получить ценность от своей способности до того, как сработает заклинание удаления.

Можно ли использовать активированную способность более одного раза?

Пока вы можете оплачивать стоимость каждый раз, вы можете использовать одну и ту же активируемую способность столько раз, сколько захотите. Хотя некоторые недавно напечатанные способности имеют формулировку «активировать только один раз за ход», чтобы ограничить это. Способности, которые требуют, чтобы вы повернули перманент, на котором они находятся, точно чувствуют, что можно использовать только один раз за ход, но вы можете использовать эту способность снова, если другая способность развернет ее.

Это особенно актуально для бесконечных циклов. Классические комбинации Exarcher Deceiver со Splinter Twin или Devoted Druid с Vizier of Remedies включают в себя активацию одной и той же способности столько раз, сколько необходимо для победы в игре.

В чем разница между срабатывающими и активируемыми способностями?

Активируемая способность — это, по сути, способность, которую вы можете контролировать при ее использовании. Очень похоже на разыгрывание заклинания, вам нужно выберите , чтобы использовать его. У вас нет прямого контроля над срабатывающими способностями, поскольку они автоматически срабатывают всякий раз, когда происходит их срабатывание.

Я уже упоминал, как можно определить активируемые способности по тому, что они содержат двоеточие. Точно так же все срабатывающие способности начинаются со слов «когда», «всякий раз» или «в», и эти слова только используются на картах Magic для обозначения срабатывающих способностей.

Способности касания активируются?

На раннем этапе обучения игре в Magic вы узнаете о вызове болезни и о том, что она применима к «способностям касания». т. е. способности, которые включают символ касания в качестве стоимости. Это активируемые способности, поскольку они содержат двоеточие, а символ крана является одной из перечисленных стоимостей.

Можно ли активировать способность существа, если у него болезнь призыва?

Болезнь вызова только останавливает существ от атаки и активации способностей, которые используют символ поворота в качестве стоимости. Пока символ касания отсутствует в списке затрат, вы все равно можете активировать эти способности.

Это также относится к способностям, которые поворачивают существо в качестве стоимости, но не используют символ поворота. Друиды наследия и рейнджеры Берхлора могут использовать себя, чтобы активировать свои способности, вызывая болезнь, а вызов больных существ также можно использовать для управления транспортными средствами.

А как насчет того, что по нему постучали?

Пока вы можете оплатить стоимость, вы можете активировать способности существа, даже если оно повернуто.

Плата за ману — активируемая способность?

Вероятно, наиболее распространенной стоимостью активируемой способности является оплата некоторого количества маны, поэтому в большинстве случаев оплата маны связана с активацией способности. Но оплата маны не по своей сути является активируемой способностью, поэтому вы должны проверить карту и найти двоеточие, чтобы увидеть, активирована способность или нет.

Способности лояльности Planeswalker-ов активируются?

Хотя в способностях planeswalker-ов нет двоеточия, это просто из-за шаблона карт planeswalker-ов. Они по-прежнему считаются активируемыми способностями.

Являются ли активируемые способности «заклинаниями»?

Мне часто задают вопрос, считается ли активация способности разыгрыванием заклинания. Это не.

Активируемые способности не активируют эффекты, такие как магия, и их стоимость не снижается картами, такими как Бессмертное Солнце. Они также не могут быть отменены контрзаклинаниями, которые говорят «контр-целевое заклинание». Но некоторые контрзаклинания и способны противодействовать им, например, Voidslime или Disallow, поскольку они специально называют активируемые способности чем-то, что им можно противопоставить.

Как искать активированные способности в Gatherer/ScryFall?

Как я уже много раз говорил, все активируемые способности имеют знак препинания двоеточие. Двоеточие также используется только в активируемых способностях и ни в чем другом. Поэтому все, что вам нужно сделать, это найти карты, в тексте правил которых есть двоеточие.

В ScryFall используйте синтаксис [o:”:”] без квадратных скобок, и вы найдете все карты, у которых есть активируемая способность, в тексте их карт. Сюда также входят карты, которые дают способности другим картам.

Какие карты останавливают активированные способности?

Многие активируемые способности очень сильны, и их отключение отключает всю карту. Карты, отключающие активируемые способности, долгое время были популярными картами ненависти.

Моя любимая карта и, вероятно, та карта, к которой прыгают самые конкурентоспособные игроки, — это Pithing Needle. Раньше я шутил, что в каждом сайдборде, в который я играл, была как минимум одна Игла, когда я начинал играть в Наследие.

Используете ли вы его, чтобы отключить Эфирный флакон, Пустошь или Джейса, Создателя разума, Pithing Needle нашел цели во многих матчах. И всего за одну ману вы вряд ли найдете другой такой же хороший вариант.

Пять лет назад мы увидели естественного преемника Pithing Needle, когда мы получили Sorcerous Spyglass в Ixalan . Хотя Подзорная труба стоит дополнительной маны, она позволяет вам взглянуть на руку вашего оппонента, чтобы увидеть, не представится ли лучший вариант, что делает ее более выгодной картой, если вы можете надежно разыграть ее.

Я выиграл игру благодаря этой карте в начале 2020 года, когда мой противник Bant Control выложил свою руку, ожидая, что я назову Око, Похитителя Корон, которого он ждал меня. Вместо этого я назвал Misty Rainforest, поскольку до сих пор они были его двумя наземными дропами, и он еще не взломал их. Затем у него не было маны для игры, и вскоре он проиграл.

Многие другие карты прошли через множество соревновательных игр, чтобы отключить способности артефактов, в том числе Null Rod, Stony Silence, Collector Ouphe и Karn, the Great Creator. Они всегда были занозой в боку колод в стиле сродства, поскольку они даже не дают артефактам повернуться для получения маны, эффективно отключая Мокс-опалы и земли артефактов.

Karn даже привел к запрету Mycosynth Lattice в Modern, поскольку превращение всего в артефакты и остановка артефактов вашего противника от активации способностей лишает его возможности снова использовать свои земли для получения маны. Обычно вы проигрываете игру, если не можете ни на что потратить ману.

Подведение итогов

Финал Вечности | Иллюстрация Дааркена

Магические правила могут быть сложными, но некоторые не так уж сложны; вы просто не смотрели на них раньше. Активируемые способности очень легко идентифицировать, и правила, связанные с ними, довольно просты, как только вы их прочитаете. Надеюсь, вы что-то вынесли из этого, и в следующий раз, когда вы пойдете спрашивать судью, работает ли ваша «Игла прокола» на карте оппонента, вы, возможно, вспомните об этом и сможете разобраться сами.

У вас есть какие-нибудь забавные истории об активируемых способностях? Какая ваша любимая активируемая способность на карте? Дайте мне знать в комментариях внизу или на официальном дискорде Draftsim.

До следующего раза, берегите себя и получайте удовольствие!

Подпишитесь на Draftsim, чтобы получать интересные статьи и устанавливать обновления:MTG Способности MTG Активируемые способности MTG Сбор колоды MTG MTG вечнозеленая механика MTG механика Правила MTG

Функции активации в нейронных сетях [12 типов и вариантов использования]

Что такое функция активации нейронной сети?

Функция активации решает, должен ли нейрон быть активирован или нет. Это означает, что он решит, важен ли вход нейрона в сеть или нет, в процессе прогнозирования с использованием более простых математических операций.

Это означает, что он решит, важен ли вход нейрона в сеть или нет, в процессе прогнозирования с использованием более простых математических операций.

Роль функции активации заключается в получении выходных данных из набора входных значений, подаваемых на узел (или слой).

Но —

Давайте сделаем шаг назад и проясним: что такое узел ?

Ну, если мы сравним нейронную сеть с нашим мозгом, узел — это копия нейрона, который получает набор входных сигналов — внешних раздражителей.

В зависимости от характера и интенсивности этих входных сигналов мозг обрабатывает их и решает, должен ли нейрон быть активирован («запущен») или нет.

В глубоком обучении это также роль функции активации, поэтому ее часто называют Передаточная функция в искусственной нейронной сети.

Основная роль функции активации заключается в преобразовании суммированного взвешенного ввода от узла в выходное значение для передачи на следующий скрытый слой или в качестве вывода.

Теперь давайте посмотрим на архитектуру нейронных сетей.

Элементы архитектуры нейронных сетей

Вот в чем дело —

Если вы не понимаете концепции нейронных сетей и того, как они работают, более глубокое погружение в тему функций активации может оказаться сложной задачей.

Вот почему рекомендуется освежить свои знания и быстро взглянуть на структуру архитектуры нейронных сетей и ее компоненты. Вот.

На изображении выше вы видите нейронную сеть, состоящую из взаимосвязанных нейронов. Каждый из них характеризуется своим весом , смещением и функцией активации .

Вот другие элементы этой сети.

Входной слойСлой ввода получает необработанные данные из домена. На этом уровне вычисления не выполняются. Узлы здесь просто передают информацию (функции) скрытому слою.

Скрытый слой Как следует из названия, узлы этого слоя не видны. Они обеспечивают абстракцию нейронной сети.

Они обеспечивают абстракцию нейронной сети.

Скрытый слой выполняет все виды вычислений над объектами, введенными через входной слой, и передает результат выходному слою.

Выходной уровень Это последний уровень сети, который переносит информацию, полученную через скрытый уровень, и в результате выдает окончательное значение.

📢 Примечание : Все скрытые слои обычно используют одну и ту же функцию активации. Однако выходной слой обычно использует функцию активации, отличную от скрытых слоев. Выбор зависит от цели или типа прогноза, сделанного моделью.

Прямое распространение и обратное распространение Изучая нейронные сети, вы столкнетесь с двумя важными терминами, описывающими движение информации, — прямое распространение и обратное распространение.

Давайте изучим их.

💡 Упреждающее распространение — поток информации происходит в прямом направлении. Входные данные используются для вычисления некоторой промежуточной функции в скрытом слое, которая затем используется для вычисления выходных данных.

Входные данные используются для вычисления некоторой промежуточной функции в скрытом слое, которая затем используется для вычисления выходных данных. В прямом распространении функция активации представляет собой математический «затвор» между входом, питающим текущий нейрон, и его выходом, идущим к следующему слою.

Проще говоря, обратное распространение направлено на минимизацию функции стоимости путем корректировки весов и смещений сети. Градиенты функции стоимости определяют уровень корректировки таких параметров, как функция активации, весовые коэффициенты, систематическая ошибка и т. д.

Зачем нейронным сетям нужна функция активации?

Итак, мы знаем, что такое функция активации и для чего она нужна, но—

Зачем она нужна нейронным сетям?

Итак, функция активации предназначена для добавления нелинейности в нейронную сеть.

Функции активации вводят дополнительный шаг на каждом уровне во время прямого распространения, но его вычисление того стоит. Вот почему —

Предположим, у нас есть работающая нейросеть без функции активации.

В этом случае каждый нейрон будет выполнять только линейное преобразование входных данных с использованием весов и смещений. Это потому, что не имеет значения, сколько скрытых слоев мы присоединяем к нейронной сети; все слои будут вести себя одинаково, потому что композиция двух линейных функций сама по себе является линейной функцией.

Хотя нейронная сеть становится проще, изучение любой сложной задачи невозможно, и наша модель будет просто моделью линейной регрессии.

3 типа функций активации нейронных сетей

Теперь, когда мы рассмотрели основные понятия, давайте рассмотрим самые популярные функции активации нейронных сетей.

Функция двоичного шага

Функция двоичного шага зависит от порогового значения, которое определяет, должен ли нейрон быть активирован или нет.

Вход, подаваемый на функцию активации, сравнивается с определенным порогом; если вход больше, чем он, то нейрон активируется, в противном случае он деактивируется, что означает, что его выход не передается на следующий скрытый слой.

Двоичная ступенчатая функцияМатематически это может быть представлено как:

Вот некоторые ограничения двоичной ступенчатой функции:

- Она не может выдавать многозначные выходные данные — например, ее нельзя использовать для задач классификации нескольких классов.

- Градиент ступенчатой функции равен нулю, что препятствует процессу обратного распространения.

Линейная функция активации

Линейная функция активации, также известная как «отсутствие активации» или «функция идентичности» (умноженная на 1,0), заключается в том, что активация пропорциональна входу.

Функция ничего не делает со взвешенной суммой входных данных, она просто выдает полученное значение.

Математически это может быть представлено как:

Однако у линейной функции активации есть две основные проблемы: ввод х.

Нелинейные функции активации

Линейная функция активации, показанная выше, представляет собой просто модель линейной регрессии.

Из-за своей ограниченной мощности это не позволяет модели создавать сложные сопоставления между входами и выходами сети.

Нелинейные функции активации устраняют следующие ограничения линейных функций активации:

- Они допускают обратное распространение, потому что теперь производная функция будет связана с входными данными, и можно вернуться и понять, какие веса во входных нейронах могут дать лучший прогноз.

- Они позволяют накладывать друг на друга несколько слоев нейронов, так как на выходе теперь будет нелинейная комбинация входных данных, прошедших через несколько слоев. Любой вывод может быть представлен как функциональное вычисление в нейронной сети.

Теперь давайте рассмотрим десять различных функций активации нелинейных нейронных сетей и их характеристики.

10 Функции активации нелинейных нейронных сетей

Функция активации сигмовидной/логистической Эта функция принимает любое действительное значение в качестве входных данных и выводит значения в диапазоне от 0 до 1.

Чем больше входное значение (более положительное), тем ближе выходное значение будет к 1,0, а чем меньше входное значение ( более отрицательное), тем ближе выход будет к 0,0, как показано ниже.

Сигмовидная/логистическая функция активацииМатематически это может быть представлено как:

Вот почему сигмовидная/логистическая функция активации является одной из наиболее широко используемых функций:

- Он обычно используется для моделей, где мы должны предсказать вероятность как результат.

Поскольку вероятность чего-либо существует только в диапазоне от 0 до 1, сигмовидная является правильным выбором из-за ее диапазона.

Поскольку вероятность чего-либо существует только в диапазоне от 0 до 1, сигмовидная является правильным выбором из-за ее диапазона. - Функция является дифференцируемой и обеспечивает плавный градиент, т.е. предотвращает скачки выходных значений. Это представлено S-образной формой сигмовидной функции активации.

Ограничения сигмовидной функции обсуждаются ниже:

- Производная функции равна f'(x) = сигмоид(x)*(1-сигмоид(x)).

Как видно из приведенного выше рисунка, значения градиента значимы только для диапазона от -3 до 3, а в других областях график становится более плоским.

Это означает, что для значений больше 3 или меньше -3 функция будет иметь очень маленькие градиенты. Когда значение градиента приближается к нулю, сеть перестает обучаться и страдает от Исчезающий градиент проблема.

- Выход логистической функции несимметричен относительно нуля.

Таким образом, выход всех нейронов будет одного знака. Это делает обучение нейронной сети более сложным и нестабильным.

Таким образом, выход всех нейронов будет одного знака. Это делает обучение нейронной сети более сложным и нестабильным.

Функция Tanh очень похожа на сигмовидную/логистическую функцию активации и даже имеет ту же S-образную форму с разницей в выходном диапазоне от -1 до 1. В Tanh , чем больше вход (более положительный), тем ближе выходное значение будет к 1,0, тогда как чем меньше вход (более отрицательный), тем ближе выход будет к -1,0.

Функция тангенса (гиперболический тангенс)Математически это может быть представлено как:

Преимущества использования этой функции активации:

- Выход функции активации тангенса центрирован по нулю; следовательно, мы можем легко отобразить выходные значения как сильно отрицательные, нейтральные или сильно положительные.

- Обычно используется в скрытых слоях нейронной сети, так как его значения находятся в диапазоне от -1 до; следовательно, среднее значение для скрытого слоя равно 0 или очень близко к нему.

Это помогает центрировать данные и значительно упрощает обучение следующему слою.

Это помогает центрировать данные и значительно упрощает обучение следующему слою.

Взгляните на градиент функции активации tanh, чтобы понять ее ограничения.

Градиент функции активации TanhКак видите, она также сталкивается с проблемой исчезающих градиентов, аналогичной сигмовидной функции активации. Кроме того, градиент функции tanh намного круче по сравнению с сигмовидной функцией.

💡 Примечание: Хотя и сигмовидная, и тангенс сталкиваются с проблемой исчезающего градиента, тангенс имеет нулевой центр, и градиенты не ограничены в движении в определенном направлении. Поэтому на практике тангенсная нелинейность всегда предпочтительнее сигмовидной нелинейности. Функция ReLU ReLU означает выпрямленную линейную единицу.

Несмотря на то, что это производит впечатление линейной функции, ReLU имеет производную функцию и допускает обратное распространение, одновременно делая его вычислительно эффективным.

Главная загвоздка здесь в том, что функция ReLU не активирует все нейроны одновременно.

Нейроны будут деактивированы только в том случае, если выход линейного преобразования меньше 0,

Функция активации ReLUМатематически это может быть представлено как:

Преимущества использования ReLU в качестве функции активации следующие:

- по сравнению с сигмовидной и тангенсной функциями.

- ReLU ускоряет сходимость градиентного спуска к глобальному минимуму функции потерь благодаря своему линейному, ненасыщающему свойству.

Ограничения, с которыми сталкивается эта функция:

- Проблема Dying ReLU, которую я объяснил ниже.

Отрицательная сторона графика делает значение градиента равным нулю. По этой причине в процессе обратного распространения не обновляются веса и смещения для некоторых нейронов. Это может создать мертвые нейроны, которые никогда не активируются.

- Все отрицательные входные значения немедленно становятся равными нулю, что снижает способность модели правильно подбирать или обучать данные.

Примечание: Для создания наиболее надежных моделей машинного обучения разделите данные на обучающие, проверочные и тестовые наборы.

Функция Leaky ReLULeaky ReLU — это улучшенная версия функции ReLU для решения проблемы Dying ReLU, поскольку она имеет небольшой положительный наклон в отрицательной области.

Leaky ReLUМатематически это можно представить как:

Преимущества Leaky ReLU такие же, как у ReLU, кроме того факта, что он допускает обратное распространение даже для отрицательных входных значений.

При выполнении этой незначительной модификации для отрицательных входных значений градиент в левой части графика становится ненулевым значением. Следовательно, мы больше не столкнемся с мертвыми нейронами в этой области.

Вот производная функции Leaky ReLU.

Ограничения, с которыми сталкивается эта функция, включают:

- Прогнозы могут не совпадать для отрицательных входных значений.

- Градиент для отрицательных значений является небольшим значением, что делает изучение параметров модели трудоемким.

Параметрическая функция ReLU — это еще один вариант ReLU, целью которого является решение проблемы обнуления градиента для левой половины оси.

Эта функция предоставляет наклон отрицательной части функции в качестве аргумента a . Выполняя обратное распространение, наиболее подходящее значение и изучены.

Параметрический ReLU

Математически это можно представить как:

Где «a» — параметр наклона для отрицательных значений.

Параметризованная функция ReLU используется, когда дырявая функция ReLU по-прежнему не справляется с проблемой мертвых нейронов, и соответствующая информация не передается на следующий уровень.

Ограничение этой функции заключается в том, что она может работать по-разному для разных задач в зависимости от значения параметра наклона 9.0169 а.

Экспоненциальная линейная единица, или сокращенно ELU, также является вариантом ReLU, который изменяет наклон отрицательной части функции.

ELU использует логарифмическую кривую для определения отрицательных значений, в отличие от негерметичных функций ReLU и Parametric ReLU с прямой линией.

Функция активации ELUМатематически это может быть представлено как:

ELU является сильной альтернативой для f ReLU из-за следующих преимуществ:

- ELU медленно сглаживается до тех пор, пока его выход не станет равным -α, тогда как RELU резко сглаживается.

- Устраняет проблему мертвого ReLU, вводя логарифмическую кривую для отрицательных значений ввода. Это помогает сети подтолкнуть веса и смещения в правильном направлении.

Ограничения функции ELU следующие:

- Это увеличивает время вычислений из-за включенной экспоненциальной операции

- Не происходит изучение значения «а»

- Проблема взрывающегося градиента

Математически это можно представить как:

строительный блок — сигмовидная/логистическая функция активации, которая работает над вычислением значений вероятности.

Вероятность

Выход сигмовидной функции находился в диапазоне от 0 до 1, что можно рассматривать как вероятность.

Но—

Эта функция сталкивается с определенными проблемами.

Предположим, у нас есть пять выходных значений 0,8, 0,9, 0,7, 0,8 и 0,6 соответственно. Как мы можем двигаться вперед с этим?

Ответ: мы не можем.

Приведенные выше значения не имеют смысла, поскольку сумма всех классов/выходных вероятностей должна быть равна 1.

Видите ли, функция Softmax описывается как комбинация нескольких сигмоид.

Вычисляет относительные вероятности. Подобно сигмовидной/логистической функции активации, функция SoftMax возвращает вероятность каждого класса.

Чаще всего используется в качестве функции активации для последнего слоя нейронной сети в случае многоклассовой классификации.

Математически это можно представить как:

Функция SoftmaxДавайте вместе рассмотрим простой пример.

Предположим, что у вас есть три класса, а это означает, что в выходном слое будет три нейрона. Теперь предположим, что ваш выходной сигнал от нейронов составляет [1,8, 0,9, 0,68].

Применение функции softmax к этим значениям для получения вероятностного представления приведет к следующему результату: [0,58, 0,23, 0,19].

Функция возвращает 1 для наибольшего индекса вероятности и 0 для двух других индексов массива. Здесь мы придаем полный вес индексу 0 и не придаем веса индексу 1 и индексу 2. Таким образом, на выходе будет класс, соответствующий 1-му нейрону (индекс 0) из трех.

Таким образом, на выходе будет класс, соответствующий 1-му нейрону (индекс 0) из трех.

Теперь вы можете видеть, как функция активации softmax упрощает решение задач классификации нескольких классов.

Swish Это функция автоматической активации, разработанная исследователями Google.

Swish постоянно соответствует или превосходит функцию активации ReLU в глубоких сетях, применяемых в различных сложных областях, таких как классификация изображений, машинный перевод и т. д.

Функция активации SwishЭта функция ограничена снизу, но не ограничена сверху, т. е. Y приближается к постоянному значению поскольку X приближается к отрицательной бесконечности, но Y приближается к бесконечности, как X приближается к бесконечности.

Математически это можно представить как:

Вот несколько преимуществ функции активации Swish по сравнению с ReLU:

- Swish — это плавная функция, которая означает, что она не меняет направление резко, как это делает ReLU вблизи x = 0.

Скорее, он плавно изгибается от 0 к значениям < 0, а затем снова вверх.

Скорее, он плавно изгибается от 0 к значениям < 0, а затем снова вверх.

- Небольшие отрицательные значения были обнулены в функции активации ReLU. Тем не менее, эти отрицательные значения могут по-прежнему иметь значение для захвата шаблонов, лежащих в основе данных. Большие отрицательные значения обнуляются по причинам разреженности, что делает ситуацию беспроигрышной.

- Функция взмаха, будучи немонотонной, улучшает представление входных данных и веса, которые необходимо изучить.

Функция активации линейной единицы гауссовой ошибки (GELU) совместима с BERT, ROBERTa, ALBERT и другими ведущими моделями НЛП. Эта функция активации мотивирована сочетанием свойств отсева, зонирования и ReLU.

ReLU и отсев вместе дают выход нейрона. ReLU делает это детерминировано, умножая входные данные на ноль или единицу (в зависимости от того, является ли входное значение положительным или отрицательным) и стохастически умножая на ноль.

Регулятор RNN, называемый zoneout, стохастически умножает входные данные на единицу.

Мы объединяем эту функциональность, умножая входные данные либо на ноль, либо на единицу, что определяется стохастически и зависит от входных данных. Умножим вход нейрона x на

m ∼ Бернулли(Φ(x)), где Φ(x) = P(X ≤x), X ∼ N (0, 1) — кумулятивная функция распределения стандартного нормального распределения .

Это распределение выбрано, поскольку входные данные нейронов имеют тенденцию следовать нормальному распределению, особенно при пакетной нормализации.

Функция активации Gaussian Error Linear Unit (GELU)

Математически это может быть представлено как:

Нелинейность GELU лучше, чем активация ReLU и ELU, и находит улучшения производительности во всех задачах в областях компьютерного зрения, обработки естественного языка и распознавания речи. .

Масштабированная экспоненциальная линейная единица (SELU) SELU был определен в самонормализующихся сетях и обеспечивает внутреннюю нормализацию, что означает, что каждый слой сохраняет среднее значение и дисперсию из предыдущих слоев. SELU включает эту нормализацию, регулируя среднее значение и дисперсию.

SELU включает эту нормализацию, регулируя среднее значение и дисперсию.

SELU имеет как положительные, так и отрицательные значения для смещения среднего значения, что было невозможно для функции активации ReLU, поскольку она не может выводить отрицательные значения.

Для регулировки дисперсии можно использовать градиенты. Для увеличения функции активации требуется область с градиентом больше единицы.

Функция активации SELUМатематически это может быть представлено как:

SELU имеет предопределенные значения альфа α и лямбда λ.

Вот основное преимущество SELU перед ReLU:

- Внутренняя нормализация выполняется быстрее, чем внешняя нормализация, что означает, что сеть сходится быстрее.

SELU является относительно новой функцией активации и нуждается в дополнительных статьях по таким архитектурам, как CNN и RNN, где она сравнительно исследуется.

Почему глубокие нейронные сети трудно обучать?

Есть две проблемы, с которыми вы можете столкнуться при обучении своих глубоких нейронных сетей.

Давайте обсудим их подробнее.

Исчезающие градиенты Как и сигмовидная функция, некоторые функции активации сжимают достаточно входного пространства в небольшое выходное пространство между 0 и 1.

изменение на выходе. Следовательно, производная становится малой. Для неглубоких сетей с несколькими уровнями, которые используют эти активации, это не является большой проблемой.

Однако при использовании большего количества слоев градиент может оказаться слишком маленьким для эффективной тренировки.

Взрывные градиенты Взрывные градиенты — это проблемы, при которых накапливаются значительные градиенты ошибок, что приводит к очень большим обновлениям весов модели нейронной сети во время обучения.

Нестабильная сеть может возникнуть, когда есть взрывные градиенты, и обучение не может быть завершено.

Значения весов также могут стать настолько большими, что переполнятся и приведут к так называемым значениям NaN.

Как правильно выбрать функцию активации?

Вам необходимо сопоставить функцию активации для выходного слоя с учетом типа решаемой задачи прогнозирования, в частности, типа прогнозируемой переменной.

Вот что вам следует помнить.

Как правило, вы можете начать с использования функции активации ReLU, а затем перейти к другим функциям активации, если ReLU не дает оптимальных результатов.

И еще несколько советов, которые помогут вам.

- Функция активации ReLU должна использоваться только в скрытых слоях.

- Функции Sigmoid/Logistic и Tanh не следует использовать в скрытых слоях, поскольку они делают модель более восприимчивой к проблемам во время обучения (из-за исчезающих градиентов).

- Функция Swish используется в нейронных сетях, имеющих глубину более 40 слоев.

Наконец, несколько правил выбора функции активации для вашего выходного слоя в зависимости от типа решаемой вами задачи прогнозирования:

- Regression — Linear Activation Function

- Binary Classification —Sigmoid/Logistic Activation Function

- Multiclass Classification —Softmax

- Multilabel Classification —Sigmoid

The activation function used in hidden layers обычно выбирается на основе типа архитектуры нейронной сети.

- Сверточная нейронная сеть (CNN) : Функция активации ReLU.

- Рекуррентная нейронная сеть : Функция активации Tanh и/или Sigmoid.

И эй, используйте эту шпаргалку, чтобы закрепить все знания о функциях активации нейронных сетей, которые вы только что приобрели 🙂

Функции активации нейронных сетей: шпаргалкаФункции активации нейронных сетей в двух словах

Молодец!

Вы дошли до этого места 😉 Теперь давайте кратко подытожим все, что вы узнали в этом уроке:

- Функции активации используются для внесения нелинейности в сеть.

- Нейронная сеть почти всегда будет иметь одну и ту же функцию активации во всех скрытых слоях. Эта функция активации должна быть дифференцируемой, чтобы параметры сети изучались при обратном распространении.

- ReLU — наиболее часто используемая функция активации для скрытых слоев.

Поскольку вероятность чего-либо существует только в диапазоне от 0 до 1, сигмовидная является правильным выбором из-за ее диапазона.

Поскольку вероятность чего-либо существует только в диапазоне от 0 до 1, сигмовидная является правильным выбором из-за ее диапазона. Таким образом, выход всех нейронов будет одного знака. Это делает обучение нейронной сети более сложным и нестабильным.

Таким образом, выход всех нейронов будет одного знака. Это делает обучение нейронной сети более сложным и нестабильным.  Это помогает центрировать данные и значительно упрощает обучение следующему слою.

Это помогает центрировать данные и значительно упрощает обучение следующему слою.

Скорее, он плавно изгибается от 0 к значениям < 0, а затем снова вверх.

Скорее, он плавно изгибается от 0 к значениям < 0, а затем снова вверх.