Стратегии : evo_lutio — LiveJournal

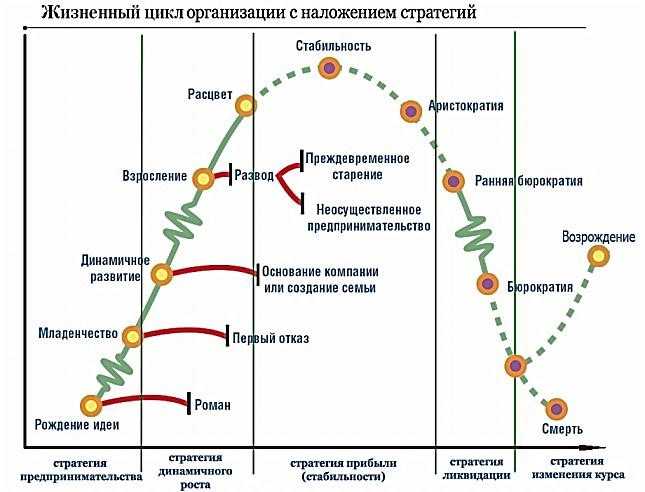

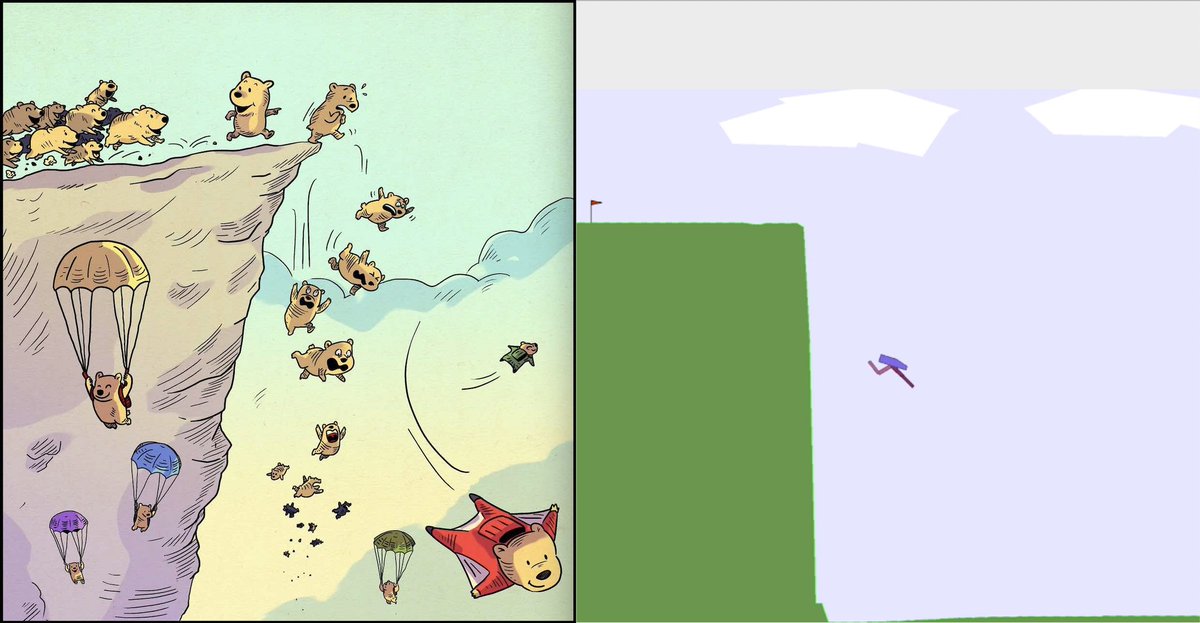

В Сети популярна вот эта шутка про стратегии:Но в своей жизни многие люди думают, что стратегии выглядят именно так.

Вчера я по случаю посмотрела начало российского сериала «Короли игры»(2007).

В первые же 10 минут там показали как раз такую вот «стратегию» с ловлей комара на соль, водку, палку и камень.

Короли игры — это команда «стратегов», которые помогают людям достигать желаемого, когда им уже отказали.

То есть эта команда создает такой контекст, чтобы воля других разворачивалась в пользу клиента.

Но это по задумке. А в реализации у этой команды получается как раз ловля комара на соль, воду, палку и камень.

Самая первая ситуация — дочь состоятельной матери, которая против маминой воли хочет увеличить грудь силиконовыми имплантами.

Мать не может ее отговорить и нанимает супер-стратегов, чтобы они помешали планам дочки.

Дальше разворачивается настоящий квест.

Дочь едет на операцию, подходит к остановке и там сидит один из команды, громко рассказывая «приятелю» про какую-то свою девушку.

Приятель громко интересуется, какая же у его девушки грудь.

«Грудь супер, — кричит стратег, чтобы услышала девушка. — Маленькая, настоящая, без силикона!»

Наевшись соли вместо сахара, наш комар, то есть нерадивая дочь своей матери, садится в автобус. Воля ее пошатнулась, мучают сомнения и информационная жажда, она жадно шарит глазами по автобусу и читает на обложке журнала, который ей сунули под нос все те же хитрые «стратеги»: «Риски пластической хирургии!».

В глазах ее троится, будто она хлебнула водки вместо воды.

Жажду свою она не утолила, а лишь расшатала себя больше.

В расшатанном состоянии она добрела до клиники. И что же? Врач опаздывает.

Мы видим, что врачу искусственно создали препятствие, выследив его машину и устроив аварию на дороге.

И вот об это препятствие, об эту услужливо подложенную палку, спотыкается наш расшатанный комар.

Пока героиня сомневается ждать врача или нет, ее добивают камнем.

К ней выходит еще один «стратег», назвавшись юристом клиники, он провожает ее в кабинет и зачитывает ей договор, где перечислены послеоперационные ужасы, за которые клиника не несет ответственности. Выслушав список возможных уродств и болезней, девушка больше не хочет силиконовую грудь. Ее комар, то есть желание импланта, подыхает.

Выслушав список возможных уродств и болезней, девушка больше не хочет силиконовую грудь. Ее комар, то есть желание импланта, подыхает.

Как же стратегу удалось захватить кабинет неприятеля на глазах администратора?

А он прикинулся газовой службой, получил ключи и дальше уже разыграл этот спектакль, пока администратор болтала по телефону.

Точно так же, как и в истории с комаром, хватило бы одного юриста, одного камня, а лучше свернутой газеты, которым его можно было прихлопнуть. Но «короли игры» не ищут легких путей, их стратегия должна быть максимально сложной и запутанной, включать в себя множество каскадерских трюков, часть из которых будут выполнять жертвы.

Комар должен обязательно поесть соли, потом обязательно напиться водки, потом непременно спотыкнуться о палку и, наконец, удариться головой о камень.

Ничего, что в реальности комары не едят соль, не пьют водку, не спотыкаются и не ударяются головой. Автор стратегии представляет на месте комара кого-то вроде себя, но только намного глупей и послушней.

И все стратегии Победителей скроены по этому лекалу.

Чуть проще или такие же сложные, но это всегда история, где нет второго субъекта, а есть лишь послушная проекция самого «стратега».

Совсем другое дело стратеги.

Вот когда хищник оценивает силы неприятеля в этой истории и в этой, он не придумывает за неприятеля его ходов.

В первом случае он видит Выскочку и решает познакомиться поближе, чтобы этой Выскочке подыграть в нужном себе направлении. Не направлять человека, а открыть его решето и посмотреть, что из этого решета может пригодиться.

Во втором случае он смотрит на поле боя дольше, чтобы понять кто с кем в союзе, а кто в оппозиции.

Он сразу увидел, что мать невесты — Штурман, рассмотрел ее характер в динамике, не только персиковое платье, потому что только для моих двоечников персиковое платье означает стремление немедленно отдаться первому встречному, а в жизни все не так. Балкон удобен тем, что видно, кто к кому подходит, кто бегает, кто на месте стоит, кто в стороне, кто в центре. На поле так и надо смотреть, отстраненно, со стороны, представляя, что вы смотрите с балкона или на карту местности. И себя на этом поле тоже нужно видеть так же, как отдельную фигуру, видя слабости вашей позиции и сильные стороны.

На поле так и надо смотреть, отстраненно, со стороны, представляя, что вы смотрите с балкона или на карту местности. И себя на этом поле тоже нужно видеть так же, как отдельную фигуру, видя слабости вашей позиции и сильные стороны.

Хищник не придумывал за мать невесты ее ходы. Он думал лишь о том, чем вызвать ее расположение.

Чтобы вызвать расположение человека, нужно увидеть его интерес.

Люди в короне и с внешним локусом имеют не интерес, а нужду, голод. Вот почему хищник в одну минуту пленяет таких людей.

Люди без короны, с нормальным локусом имеют нормальный интерес. И они тоже проникаются симпатией к рыбаку, а он проникается симпатией к ним, потому что они умеют видеть обратную связь и общаться в границах.

Вот это стратегия, противоположная стратегии Победителя.

Победитель гоняется за человеком с копьем как за добычей, он овеществляет другого. А рыбацкая стратегия — самому предложить добычу, увидев в другом субъекта.

Если другой — Победитель, он сам будет гоняться за рыбаком, сливая все. Только рыбак не возьмет слитое, а хищники могут взять, часть или все, смотря какой хищник, у хищников разная степень этичности.

Только рыбак не возьмет слитое, а хищники могут взять, часть или все, смотря какой хищник, у хищников разная степень этичности.

Если другой имеет нормальный локус контроля, он не будет гоняться с копьем, он попытается предложить встречную добычу и, если рыбаку интересно, возникнет обмен.

С хищником будет то же самое. Если вы не погонитесь за ним, а предложите ему что-то интересное для него, он согласится на равноценный обмен.

То есть хищник — существо безопасное, если у вас нет короны.

Опасен хищник только для человека с большой короной и с плохими границами.

Если хотите, давайте эту тему обсудим.

А еще приведите примеры смешных «стратегий» с женских и мужских тренингов, курсов, из блогов, все равно откуда.

Только ссылки закрашивайте.

Стратегия и искренность : evo_lutio — LiveJournal

Не раз поднимавшаяся, но всегда актуальная тема.

Надо ли стратегу быть искренним? И насколько искренность совмещается со стратегическим поведением?

Отвечу сразу.

Быть искренним надо обязательно всем!

Искренность идеально сочетается со стратегическим поведением, если это именно оно. То и другое тесно связано.

Почему так важно быть искренним?

Всю информацию об отношении к ним других люди воспринимают невербально. По взглядам, интонациями, жестам, движениям, другим нюансам. У людей за время эволюции сформировались огромные возможности для социальной дифференциации, то есть для опознания: свой, чужой, опасный, безопасный, любящий, равнодушный и т.д.

Большую часть воспринятой информации люди не осознают, а чувствуют. И даже чувствуют не все, поскольку психика фильтрует самое актуальное и скрывает стрессогенное. Именно поэтому несчастно влюбленные имеют столько иллюзий. Чем важнее нам отношение человека, тем больше иллюзий, поскольку сильней угроза стресса. Но любой, вышедший из любовной аддикции, может вспомнить и воссоздать параллельный план своих эмоций: он был безмятежен, но одновременно тревожился, он доверял, но одновременно сомневался. Он вытеснял реальное представление, не специально, так получалось само. Это делала за него психика. Тем не менее, чужие эмоции мы отражаем довольно точно, особенно пока человек для нас не очень значим. Отсюда пушкинское: «чем меньше женщину бы любим, тем легче нравимся мы ей». Легче — потому что иллюзий меньше. Хотя эта идея имеет и оборотную сторону: мотивации мало, то есть огня и потока. Наша задача — учиться видеть реальность, имея высокую мотивацию. А не выбирать между онегинской отморозкой и слепым фанатизмом аддикта.

Он вытеснял реальное представление, не специально, так получалось само. Это делала за него психика. Тем не менее, чужие эмоции мы отражаем довольно точно, особенно пока человек для нас не очень значим. Отсюда пушкинское: «чем меньше женщину бы любим, тем легче нравимся мы ей». Легче — потому что иллюзий меньше. Хотя эта идея имеет и оборотную сторону: мотивации мало, то есть огня и потока. Наша задача — учиться видеть реальность, имея высокую мотивацию. А не выбирать между онегинской отморозкой и слепым фанатизмом аддикта.

Но факт остается фактом, люди хорошо чувствуют чужую фальшь. Именно поэтому никогда (никогда) не используйте ни одну рыбацкую технику или инструмент (шары, крючки, пики и т.д.), если это неискренне, если вы не находите горячего отзыва в своей душе. На влюбленного, погруженного в иллюзии человека, это конечно подействует. Но зачем на него действовать? Влюбленные и ругань принимают за шары, то есть способны переворачивать все с ног на голову. И даже влюбленные почувствуют диссонанс, просто не захотят заметить его и осознать. Все остальные и диссонанс почувствуют и неприязнь к вам испытают. То есть инструменты не работают без потока, а поток — это ваши искренние эмоции (влечение, гнев, интерес, радость, печаль и т.д.). Понятно? Не хочется больше это повторять. Не работают инструменты, если вы притворяетесь. Даже у опытных рыбаков не сработают, но они и не будут пытаться варить кашу из топора, если негде раздобыть крупу.

Все остальные и диссонанс почувствуют и неприязнь к вам испытают. То есть инструменты не работают без потока, а поток — это ваши искренние эмоции (влечение, гнев, интерес, радость, печаль и т.д.). Понятно? Не хочется больше это повторять. Не работают инструменты, если вы притворяетесь. Даже у опытных рыбаков не сработают, но они и не будут пытаться варить кашу из топора, если негде раздобыть крупу.

Есть вторая причина, почему надо быть всегда искренним. Это важно ради самоуважения. Если вы изображаете чувства и эмоции, которых не испытываете, вы предаете себя. Вы — это ваши чувства и эмоции, и если вы притворяетесь, вы дистанцируетесь от себя, запираете себя в темный чулан и живете без себя, бездушной оболочкой. Ради чего вы это делаете? Чтобы получить выгоду? Во-первых, не выйдет, см. выше. Во-вторых, эту выгоду получили бы не вы, вы же заперты в темном чулане.

Поэтому никогда не притворяйтесь. Будьте искренними.

Теперь о том, как это сочетается со стратегическим поведением. Точнее не так. Почему только это и сочетается со стратегическим поведением?

Точнее не так. Почему только это и сочетается со стратегическим поведением?

По тем же причинам, которые выше описаны. Действуя искренне, вы действуете в потоке, вы сильней и вы не вызываете в людях ощущение фальшивки, вранья, диссонанса между вашей вербаликой и невербаликой. Вам доверяют и правильно делают, вы искренни. Обратите внимание на это слово «искренность». Вы искритесь энергией, когда действуете и говорите искренне. Даже самые гениальные лжецы и авантюристы действовали искренне, поскольку верили сами в свою ложь до самой глубины души. Но это отдельная, скользкая тема, можно ли добиться искренности, виртуозно обманув себя. Большинству людей это не под силу. И это неэкологично, по отношению к себе в первую очередь. Как-нибудь потом разберем эти случаи. Пока остановимся на том, что вы должны чувствовать все, что говорите и делаете. Не играть чужих ролей.

Почему же люди сомневаются, что искренность и стратегия совместимы?

Из-за разрыва между эмоциями и рассудком._27.png) Из-за того самого «ум с сердцем не в ладах». Правильным кажется одно, а хочется другого. Поэтому кажется, что надо выбрать: либо от ума действовать, либо от сердца.

Из-за того самого «ум с сердцем не в ладах». Правильным кажется одно, а хочется другого. Поэтому кажется, что надо выбрать: либо от ума действовать, либо от сердца.

Чтобы учиться рыбалке (и другие ресурсы прокачивать) надо очень твердо понять, что разрыв между умом и сердцем — это ненормальная ситуация, это дефолт Королевы и Короля, это внутренний конфликт. Это частая очень ситуация, но это так же ненормально, как и инфантилизм взрослых. То есть для детского возраста такой разрыв норма, а для взрослой личности — нет. Наша задача помирить ум и сердце, вывести Короля и Королеву в баланс, только тогда будет возможна эго-интеграция и рост личностной силы.

Но важно то, что даже неинтегрированная личность, даже самая инфантильная личность все равно может быть искренней и действовать стратегически, точнее должна быть искренней, когда учится действовать стратегически. И сейчас я покажу, как это нужно делать.

То, что люди называют «искренность» часто состоит из множества противоречивых и быстро сменяющихся эмоций.

Вот Вася и Маша живут в дефолте. Утром Маша хочет Васю придушить подушкой, вспоминая вчерашнее. Потом отвлекается от обиды и начинает бояться, что он не наденет шарф и простынет. На работе переживает о своей утренней злобе и искренне любит Васю. После обеда, глядя на атлетичного коллегу, думает о том, как ей Вася надоел в сущности и какой же он урод. К вечеру начинает переживать, что Вася вернется домой слишком поздно и она будет изводиться от ревности. А когда Вася возвращается домой вовремя, она думает, что слишком рано вышла замуж и не за того.

В какой момент Маша искренне чувствует? Во все моменты разом. Ее эмоции это противоречивый, разнонаправленный поток. Более того, этот поток может много раз смениться не за день, а во время одного короткого диалога с Васей, от любви до ненависти.

Некоторые думают, что вести себя абсолютно искренне, это каждую минуту демонстрировать изменения своих эмоций. Но представьте себе, во что тогда превратится жизнь Маши, если она будет обо всех своих переменах Васе сообщать. «Знаешь, Вася, хочу быть честной с тобой, я тебя ненавижу». «Вася, должна тебе признаться, что никакой ненависти сейчас не чувствую, наоборот думаю, как бы укрепить наш брак». «Вася, ты лучший из мужчин, клянусь». «Вася, ты урод и проходимец, честное слово».

«Знаешь, Вася, хочу быть честной с тобой, я тебя ненавижу». «Вася, должна тебе признаться, что никакой ненависти сейчас не чувствую, наоборот думаю, как бы укрепить наш брак». «Вася, ты лучший из мужчин, клянусь». «Вася, ты урод и проходимец, честное слово».

Собственно, примерно такое и происходит во многих парах, где люди настолько инфантильны, что считают важным сообщить назначенной мамочке в лице партнера обо всех своих переживаниях и ощущениях. Оставьте в покое человека, ироды, смилуйтесь. Искренность и постоянный поток детских экскрементов не имеют ничего общего.

Если вы противоречивы и переменчивы в эмоциях, но хотите научиться действовать стратегически, вам нужно выбрать ту эмоцию, которая, во-первых, наиболее стабильна, во-вторых, соответствует цели стратегии. То есть если вы решили улучшить брак с Васей, вы должны выбрать из вороха своих эмоций любовь к нему. Бывает любовь? Если нет или очень редко, стратегию на этом не построишь. Потока нет. Нет крупы для каши. Если любовь бывает нередко, можно пробовать, но только эту эмоцию придется сделать стабильней и держать свой поток в ее русле.

То есть начинающий стратег (рыбак) от рыбы отличается тем, что сам выбирает русло. Смотрите, он не роет канал (это уровень высшего мастерства, мы о таком пока и говорить не будем, но конечно и там нет притворства никакого, должен начаться реальный поток в вырытом канале), он выбирает то русло, которое УЖЕ есть и которое вполне глубоко, то есть в нем есть такая эмоция, часто, сильно, но нестабильно. Если его поток то и дело меняет русло, разворачивается или застревает в плотинах, он направляет этот поток в русло нужной ему эмоции и старается держать.

Как направляется и держится поток?

Если наша Маша решила выйти из дефолта с Васей, поняв, что, хоть он и урод, но дорог ей и все еще любим, она должна остановить свои качели и перестать метаться. Пока она мечется, надеясь втайне, что Вася ее отловит и убедит, что им надо быть вместе, Вася ведет себя все хуже. Дефолт постепенно разрушает связь Маши и Васи, поскольку природа стремится к равновесию. Если пара не выходит в баланс, она какое-то время мучает друг друга в дефолте, а потом расстается. Или расходится по комнатам и живет как соседи, что тоже по сути- развод. Если Маша не хочет доверять дефолту разрушить ее брак, а хочет сама поучаствовать как личность (а не бревно в реке) и стратегическим путем выйти из дефолта, она должна остановить свои эмоциональные качели изнутри и сфокусироваться на любви к Васе.

Или расходится по комнатам и живет как соседи, что тоже по сути- развод. Если Маша не хочет доверять дефолту разрушить ее брак, а хочет сама поучаствовать как личность (а не бревно в реке) и стратегическим путем выйти из дефолта, она должна остановить свои эмоциональные качели изнутри и сфокусироваться на любви к Васе.

Обратите еще раз внимание. Если любви к Васе уже нет, притворяться не надо. Надо быть честной и смелой. Не получится ничего, только самоуважение упадет еще ниже и энергии станет меньше. Но если любовь к Васе есть и занимает среди других эмоций важное место, не где-то в дальнем углу пробуждается раз в сто лет, а достаточно громко звучит в сердце Маши, она может попытаться держать свой поток в этом русле, не давая ему все время менять направление.

Это делается достаточно легко на самом деле и вы это делаете постоянно, просто не осознаете, не управляете этим сами, опираетесь на внешнее. Вы собираете женсоветы или мальчишники, чтобы услышать чужое мнение и перестать метаться, пожить хотя бы несколько часов в непротиворечивом состоянии. То есть пока вы так мечетесь, любое мнение, особенно логично сформулированное или от человека, которого вы цените, направляет ваш поток и держит какое-то время в одном русле. Подружка говорит Маше, что Вася совсем обнаглел и надо срочно завести любовника. И Маша решает, да, заведу, ей и самой уже такие мысли приходили, поэтому она начинает думать о любовнике. Потом, через какое-то время, опять может начать бояться Васю потерять и мечтать укрепить брак. Васе приятель говорит, что с Машей надо пожестче, запретить ей пилу и скалку. Вася согласен, он и сам об этом думал, он решает поменять линию поведения на более жесткую. Но потом может опять усомниться и испугаться, что Маша обидится и любовника заведет для утешения. В общем, пока люди на качелях, они очень внушаемы и поддаются влиянию со стороны. Внутренней стабильности нет, качает от любого ветра.

То есть пока вы так мечетесь, любое мнение, особенно логично сформулированное или от человека, которого вы цените, направляет ваш поток и держит какое-то время в одном русле. Подружка говорит Маше, что Вася совсем обнаглел и надо срочно завести любовника. И Маша решает, да, заведу, ей и самой уже такие мысли приходили, поэтому она начинает думать о любовнике. Потом, через какое-то время, опять может начать бояться Васю потерять и мечтать укрепить брак. Васе приятель говорит, что с Машей надо пожестче, запретить ей пилу и скалку. Вася согласен, он и сам об этом думал, он решает поменять линию поведения на более жесткую. Но потом может опять усомниться и испугаться, что Маша обидится и любовника заведет для утешения. В общем, пока люди на качелях, они очень внушаемы и поддаются влиянию со стороны. Внутренней стабильности нет, качает от любого ветра.

Для стратега важна воля (стратегическое поведение — это проактивное, а проактивность — это и есть воля, саморегуляция на внутреннем круге ресурсов в моей книге «Любовь: секреты разморозки»). Воля помогает человеку не метаться от эмоции к эмоции, а выбрать что-то одно и держать на этом фокус внимания.

Воля помогает человеку не метаться от эмоции к эмоции, а выбрать что-то одно и держать на этом фокус внимания.

Маша должна выбрать, либо она разводится с Васей и тогда направить свою стратегию на организацию самостоятельной жизни, либо она пытается выйти из дефолта и тогда направляет стратегию на построение отношений с Васей. Пока же она мечется от «Ты мне надоел» до «Я не хочу тебя терять», стратегии не будет. Представьте себе этого полководца, который командует войску то наступать, то отступать, то снова наступать.

И самое важное здесь, что пока люди на качелях, у них не только стратегии нет, но и искренности нет тоже. Ну какая искренность, если пять минут назад признавался в любви, а сейчас прогоняет? Кто поверит в искренность такого человека? Он и сам не верит себе, поскольку чувствует, насколько его эмоции переменчивы, не видит, что они настоящие, глубокие, сильные. Искренности нет при поверхностных эмоциях! Искренность появляется, когда ваша эмоция становится стабильной и превращается в чувство.

То есть искренности у непроактивной, инфантильной личности нет вообще, есть какой-то сумбур внешних влияний и хаотичных реакций.

А стратегическое поведение помогает стать действительно искренним, сделать эмоции сильными и осознанными, укрепиться в своем отношении. А потом, благодаря стратегии, выстраивается новая ситуация отношений, которая поддерживает чувства, сама по себе тоже делает вашу искренность (и искристость) больше. То есть если Маше удастся выйти из дефолта, если они помирятся с Васей и перестанут друг друга обижать, ее отношение к нему станет стабильно хорошим, для качелей не останется места.

Но обратите внимание: если во время выхода из дефолта у Маши не получится быть искренне любящей, хотя бы искренне симпатизирующей, а придется частенько притворяться, у нее тоже ничего не получится. Притворство не работает, поскольку энергии не имеет. Поэтому если вы пытаетесь держать фокус на эмоции, но у вас не выходит (например Маша пытается любить Васю, но он ее постоянно бесит, пытается его хотеть, но он ее отвращает), вам нужна другая стратегия, эту вы не тянете, нет для нее потока, цель нужна попроще. Например, не вернуть страсть, а просто наладить для начала миролюбивое соседство, исходите из своих возможностей, то есть слушайте сердце свое — это банк энергии, а рассудок всего лишь казначей.

Например, не вернуть страсть, а просто наладить для начала миролюбивое соседство, исходите из своих возможностей, то есть слушайте сердце свое — это банк энергии, а рассудок всего лишь казначей.

Друзья, у вас получается стратегическое поведение? Есть успехи?

Я в соцсетях:

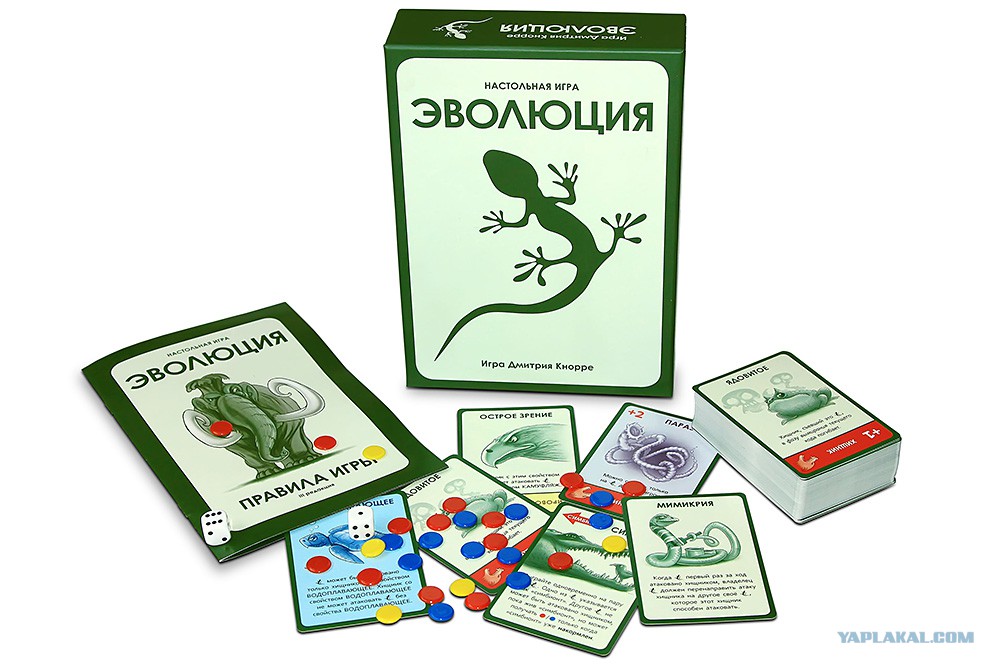

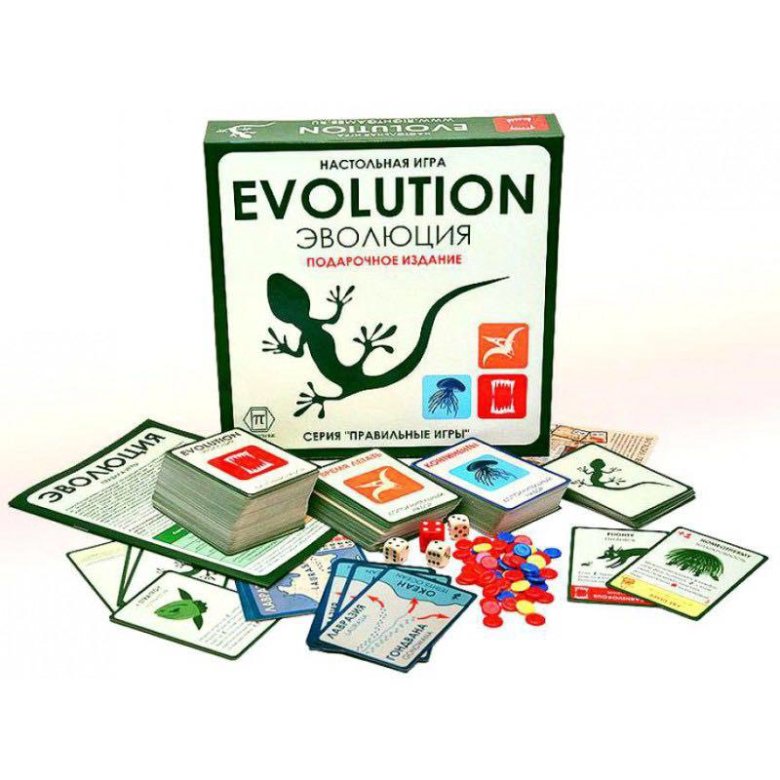

Evolution / Эволюция : nastolki — LiveJournal

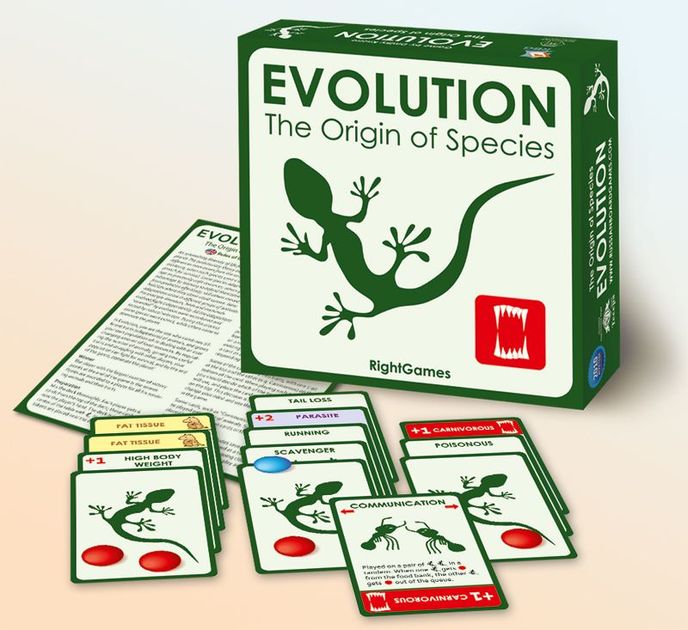

Только ленивый еще не написал про одну из самых успешных и умных российских настольных игр. Сегодня мы присоединимся к их числу. Вручаем игре орден «Золотого гекса» и предлагаем вам почитать про нее и все дополнения!| Русское название: Эволюция Зарубежное название: Evolution, Evolution. The origin of species Геймдизайнер: Дмитрий Кнорре Тип: карточная Сайт: http://rightgames.ru/ | Число игроков (и оптимальное): 2-4 (4) Сложность освоения: низкая Время подготовки: 5-15 минут Время партии: 30-60 минут |

Чем больше мы познаем неизменные законы природы, тем более невероятными становятся для нас чудеса.  Чарльз Роберт Дарвин |

Авторы статьи: Александр flaring_tille Бабулин и Ольга hvatograf Воронова

Представьте себе Лох-несское чудовище: двадцать метров длиной; с длинных и острых, словно мачете, зубов, капает яд; под изъеденной паразитами кожей скрывается толстенный слой жира; на охоту оно всплывает из неведомых глубин; не брезгует падалью. А в случае опасности готово скрыться в норке. Вы себе это представляете? Думаете, природа могла бы допустить существование подобного монстра? Едва ли. Но в игре «Эволюция» вы можете себе позволить поспорить с природой…

Происхождение видов

Все тяготы естественного отбора сокрыты в небольшой коробочке зеленого цвета. Там — столь же простой, как природные механизмы, инвентарь: 84 карты из глянцевого картона, 25 фишек еды разного цвета, 2 кубика, пара страничек с правилами.

Это интересно: игру создал настоящий биолог, выпускник биофака МГУ Дмитрий Алексеевич Кнорре, в настоящее время работающий научным сотрудником НИИ физико-химической лаборатории. Он рассматривает ее как способ популяризации любимой науки.

Он рассматривает ее как способ популяризации любимой науки.

Все карточки — двусторонние. С одной стороны — идентичные «ящерки», обозначающие в игре животное без дополнительных свойств. С другой — одно-два свойства, которыми можно наделить зверя. Или рыбу, земноводное, птицу — как пожелаете.

Каждый ход в игре состоит из четырех фаз. Перед первой фазой первого хода каждому игроку выдается по шесть карт. Далее каждый участник создает своих животных с неограниченным количеством не повторяющихся свойств. Существо может быть хищное (то есть поедать других животных, выложенных на столе), большое, водоплавающее, быстрое, ядовитое и так далее. Доступно пятнадцать различных свойств, которые можно применить к своему питомцу. Одну особенность можно «подарить» соседскому гаду — скинуть на него паразита, который будет каждый ход требовать себе дополнительно две «еды». Дополнительное питание требуют для себя также хищники и большие животные.

Есть карточки, которые играются сразу на пару своих существ, — симбиоз, сотрудничество и взаимодействие. С их помощью можно создавать на столе пищевые цепи.

С их помощью можно создавать на столе пищевые цепи.

Животные эволюционировали, со стола доносятся рык, тявканье и писк. Пора кормить тварей. Вторая фаза состоит в определении кормовой базы. В игру вступает один или два кубика, в зависимости от числа игроков. По итогам броска выясняем, сколько фишек еды кладется на стол.

Третья фаза — питание. Каждый питается по-своему. Кто-то просто забирает фишки со стола, кто-то ворует фишки у соседей, кто-то ест собратьев, кто-то доедает за хищником. Все как в саванне или тундре.

Сами понимаете, животные в таком режиме выживают далеко не у всех. И даже те, кто не съеден, могут умереть от голода — фишек на всех хватает нечасто. Наступает последняя фаза, вымирание. Разобравшись, кто выжил, а кто отправился на тот свет, каждый игрок получает на одну карточку больше, чем у него осталось подопечных. И все радостно переходят к следующему этапу эволюции.

Игра кончается, когда кончается колода карт. И победителем становится тот, у кого к концу на руках оказывается либо больше всего животных, либо самые «навороченные» звери.

В «Эволюции», несмотря на то что придумана она биологом, а не специалистом по играм, есть простор и для стратегического, и для тактического мышления — это не просто тренажер по эволюционным процессам. Сделанная так, что очевидной дороги к победе в ней быть не может, эта игра, если не сидеть за ней дни напролет, надоест не скоро. И при этом она вполне может привлечь и хардкорного мастера кубика и карточки, и простого смертного.

Увлекательность 2 из 3

достоинства: захватывающе подан эволюционный процесс, игроки постоянно на грани вымирания

недостатки: малое разнообразие действий

Взаимодействие 3 из 3

достоинства: сильная конкуренция, плотное влияние друг на друга

недостатки: все взаимодействие — поедать зверюшек противника

Проработка 3 из 3

достоинства: игра легка в освоении, правила расписаны доступно, игра предельно логична большое влияние случайностей

недостатки: несбалансированные карты, неполная трактовка правил

Атмосфера 2 из 3

достоинства: живая тема игры

недостатки: схематичные картинки

Качество 2 из 3

достоинства: выдержанная стилистика, компактность коробки

недостатки: маловато фишек, непрочная коробка

Вердикт: Спокойная и познавательная игра с мощным биологическим уклоном, которая подойдет всем и каждому.

Автор статьи: Дмитрий pastushok Трубицин

Происхождение видов, если наблюдать за ним в ускоренном темпе, — захватывающий процесс. Драма жизни, полная конфликтов, хитрых решений и неожиданных поворотов. Однако же до сих пор принцип «выживает самый приспособленный» не обретал столь явного воплощения в настольной игре.

Всё, что есть у демиургов в начале «Эволюции», — шесть карт на руках. Любую карту можно сыграть рубашкой вверх как новое животное, а можно — как свойство для уже введённого в игру создания. Каждый ход запас карт игроков возрастает по числу подконтрольных животных. Когда общая колода исчерпана, побеждает владелец наибольшего числа высоко забравшихся по ветвям эволюции существ.

Среди прочих выделяется такое свойство, как хищничество. Изначально животные вынуждены полагаться на милость природы, которая каждый ход дарует урожай — порой щедрый, сулящий процветание всем игрокам, а порой скупой, грозящий смертями от голода. Хищник же заботится о себе сам. Он кормится, нападая на других существ, в том числе тех, что принадлежат чужим игрокам.

Изначально животные вынуждены полагаться на милость природы, которая каждый ход дарует урожай — порой щедрый, сулящий процветание всем игрокам, а порой скупой, грозящий смертями от голода. Хищник же заботится о себе сам. Он кормится, нападая на других существ, в том числе тех, что принадлежат чужим игрокам.

Однако и хищникам живётся нелегко. Cвойства, вроде «быстрое», «ядовитое», «норное», спасают травоядных от посягательств острозубых охотников. А насытиться травой мясоеду проблематично. Так что творить свою фауну следует с прозорливостью и вниманием к текущей среде обитания.

Устройство «Эволюции» располагает к дополнениям. В базовой игре свойств — пара десятков, в то время как природа подсказывает ещё сотни и сотни. Первое расширение, «Время летать», лишь укрепляет ощущение бескрайнего потенциала. Помимо новых свойств, оно радует новыми жетонами пищи, благодаря которым уже шесть игроков могут внести свою лепту в дело развития видов. Оптимальное число для быстрой игры, где ходы стремительно сменяют друг друга, втискивая эпохи в минуты.

И лишь один существенный недостаток мешает водрузить «Эволюцию» на постамент всемирной славы — посредственное оформление. Символические иллюстрации довольно милы, но эта оригинальная и удачная отечественная разработка достойна куда лучшего.

Итог: Игра международного уровня, которой недостаёт только достойного оформления.

Первое официальное дополнение к игре, вышедшее в 2011 году на русском языке, и перевыпущенное также на английском, французском и немецком языках в 2012 году. Дополнение добавляет создаваемым животным новые способности и увеличивает максимальное количество игроков до шести.

«Эволюция. Время летать» — первое дополнение к карточной игре «Эволюция». Включает 42 карты, на оборотной стороне каждой из которых приведено одно из десяти новых свойств. Среди них и давшее название выпуску — «Полёт». Существо с таким свойством не может быть атаковано хищником, у которого столько же или больше свойств. Кроме того, в дополнении представлены свойства, способствующие успешной охоте хищника, новые защитные свойства, новый вид паразита, свойства, необходимые для того, чтобы пережить голодный год и т.

д.

д.«Время летать» не является самостоятельной игрой, и карты данного выпуска замешиваются в общую с базовым комплектом колоду. При этом число возможных участников расширяется до шести. При игре вдвоём или втроём рекомендуется сократить состав колоды — убрать половину карт, что не сложно, поскольку все карты базового комплекта и дополнения представлены в чётном количестве. Описание с сайта tesera.ru

Автор статьи: Дмитрий rhunwolf Тэлэри

Огромный протоконтинент Пангея распался на две неравные части. Подхваченные извержениями, тайфунами, цунами и общим туристическим ажиотажем, все бросились переселяться. Повсюду кипел великий исход зверей, и каждый чесал задней лапой рога в раздумьях, куда податься: «Лавразия? Гондвана? Океан?»

Оригинальная «Эволюция» ещё в 2010 году поразила нас тем, как можно легко, лаконично и увлекательно переложить борьбу видов в карточную игру. Спрессовывая миллионы лет в минуты, мы создаём новые виды, и продолжаем изменять их. Звери учатся прятаться в норах, плавать или питаться мясом бывших товарищей.

Звери учатся прятаться в норах, плавать или питаться мясом бывших товарищей.

Совсем недавно вышло второе дополнение «Континенты». И вот в нём-то появился принципиально новый игровой уровень. Игровой процесс стал больше похож на реальную эволюцию и обрёл черты стратегии. Вместо одной общей кормовой базы появилось три. Два континента, один побогаче, второй победнее. И колыбель жизни — жестокий мировой океан, в котором нет такого понятия, как урожай, и объём доступной пищи всегда фиксирован.

Мы можем создавать новых зверей на любом континенте. Карты дополнения позволяют мигрировать между ними в поисках лучшей доли. Новые комбинации карт позволяют «передавать» невыгодные свойства другим животным и даже выползать из океана на твердь земную.

Но дополнение не лишено и недостатков. Во первых, поблёкли парные свойства: если один из симбионтов «переезжает» с Гондваны в Лавразию, он теряет связь с другим. Во-вторых, считывать стратегический расклад на столе стало сложнее. Деление на 3 локации происходит только в уме, на практике же каждый игрок раскладывает животных около себя. Из-за этого не всегда можно понять, кто где находится, да и для игры теперь нужно в два раза большее пространства. А в третьих — слабое оформление по-прежнему отделяет «Эволюцию» от титула лучшей российской игры.

ИТОГ: Оригинальная «Эволюция» по праву может называться одной из лучших отечественных настольных игр. Дополнение «Континенты» делает её сложнее и стратегичнее, добавляя в борьбу видов новый аспект — территориальное соперничество.

В 2011 году к игре также вышло неофициальное авторское дополнение «Ледниковый период», добавляющее к игре элемент случайности. Перед каждым ходом разыгрывается карта сил природы. Сайт: http://tesera.ru/game

Эволюция желаний: стратегии выбора потенциальных партнеров

Forbes Woman публикует отрывок из книги Дэвида Басса «Эволюция сексуального влечения. Стратегии поиска партнеров» издательства «Альпина Паблишер».

Как в процессе эволюции формировались требования мужчин и женщин к представителям противоположного пола и их стратегии выбора потенциальных партнеров? Как объяснить с точки зрения развития человечества существование и моногамии, и случайных связей? Как все эти феномены меняются со временем? На эти вопросы в своей книге пытается ответить эволюционный психолог Дэвид Басс. Forbes Woman приводит два отрывка из произведения, в которых автор пытается объяснить, действительно ли стоит винить СМИ и рекламу в возникновении сегодняшних стандартов красоты.

Читатели Forbes Woman могут воспользоваться 10%-ной скидкой на любые книги «Издательской группы «Альпина» по промо-коду forbes до 31 августа 2017 года.

Эволюционные корни мужских требований

Большое значение, которое мужчины придают внешности женщины, — вовсе не общий закон животного мира. У многих других видов, например у павлинов, именно самки оценивают внешность самцов, а не наоборот. Точно так же не универсально мужское предпочтение молодости. Самцы некоторых других приматов, например орангутангов, шимпанзе и японских макак, предпочитают более зрелых самок, которые уже продемонстрировали свои репродуктивные способности, они практически не проявляют сексуального интереса к юным самкам из-за их более низкой фертильности. Мужчины имеют дело с уникальным набором адаптивных задач, и их эволюционная сексуальная психология также уникальна. Они предпочитают молодость из-за центральной роли брака в сексуальном поведении людей. Их предпочтения связаны с будущим репродуктивным потенциалом женщины, а не с возможностью зачатия в данный момент. Они придают так много значения внешности, поскольку она несет большое число надежных признаков репродуктивного потенциала партнерши.

Их предпочтения связаны с будущим репродуктивным потенциалом женщины, а не с возможностью зачатия в данный момент. Они придают так много значения внешности, поскольку она несет большое число надежных признаков репродуктивного потенциала партнерши.

Мужчины всего мира хотят иметь привлекательных, молодых и сексуально верных жен, которые сохраняют верность на протяжении длительного периода. Возникновение этих предпочтений нельзя приписать западной культуре, капитализму, узости взглядов белых англосаксов, СМИ или промыванию мозгов с помощью рекламы. Они универсальны для всех культур, и нет такой культуры, где они бы не присутствовали. Это глубоко укоренившиеся психологические адаптации, которые управляют нашими решениями в сфере поиска партнера, точно так же, как наши эволюционные вкусовые предпочтения определяют решения в сфере питания.

Как это ни странно, предпочтения мужчин-гомосексуалистов лишь доказывают глубину этих возникших в процессе эволюции психологических механизмов. Тот факт, что внешность занимает центральное место в предпочтениях геев, а юность — главный атрибут их стандартов красоты, позволяет утверждать, что даже различия в сексуальной ориентации не могут изменить этих фундаментальных мужских адаптаций.

Тот факт, что внешность занимает центральное место в предпочтениях геев, а юность — главный атрибут их стандартов красоты, позволяет утверждать, что даже различия в сексуальной ориентации не могут изменить этих фундаментальных мужских адаптаций.

Такие предпочтения расстраивают некоторых своей несправедливостью. Мы можем лишь ограниченно изменять свою внешность, и одни люди рождаются, или становятся, более красивыми, чем другие. Красота недемократична. Женщина не может изменить свой возраст, и ее репродуктивная ценность с возрастом снижается гораздо быстрее, чем у мужчин, — эволюция обошлась с женщинами жестоко, по крайней мере в этом отношении. (Далее мы увидим, как эволюция жестоко обошлась с мужчинами, которых в среднем ожидает более ранняя смерть.) Женщины борются с увяданием с помощью косметики, пластической хирургии и занятий фитнесом. Этим пользуется косметическая индустрия, бюджет которой в США составляет $8 млрд в год.

После прочитанной мною лекции о половых различиях предпочтений в отношении партнера одна женщина заметила, что мне не стоит распространяться об этом, поскольку такая информация расстраивает женщин. На ее взгляд, женщинам и без того тяжело живется в мире, где доминируют мужчины, а тут еще ученые с рассказами о том, что их проблемы в сфере поиска партнера связаны с эволюционной психологией мужчин. Однако утаивание правды вряд ли поможет, точно так же, как утаивание предпочтения спелых и сочных фруктов, вряд ли изменит наши пристрастия. Предъявлять мужчинам претензии за то, что они предпочитают красивых, молодых и верных жен, все равно что предъявлять претензии тем, кто ест мясо, за то, что они предпочитают животный белок. Убеждать мужчин в том, что их не должны возбуждать признаки юности и здоровья, все равно что убеждать их не чувствовать сладкий вкус, когда на языке оказывается сахар.

На ее взгляд, женщинам и без того тяжело живется в мире, где доминируют мужчины, а тут еще ученые с рассказами о том, что их проблемы в сфере поиска партнера связаны с эволюционной психологией мужчин. Однако утаивание правды вряд ли поможет, точно так же, как утаивание предпочтения спелых и сочных фруктов, вряд ли изменит наши пристрастия. Предъявлять мужчинам претензии за то, что они предпочитают красивых, молодых и верных жен, все равно что предъявлять претензии тем, кто ест мясо, за то, что они предпочитают животный белок. Убеждать мужчин в том, что их не должны возбуждать признаки юности и здоровья, все равно что убеждать их не чувствовать сладкий вкус, когда на языке оказывается сахар.

У многих сохраняется идеалистическая уверенность в том, что стандарты красоты искусственны и навязываются обществом, что красота — это нечто исключительно поверхностное, что представители разных культур придают очень разное значение внешности и что западные стандарты — порождение СМИ, родителей, цивилизации или прочих социальных факторов. Однако стандарты привлекательности вовсе не искусственны — они отражают признаки молодости и здоровья, а следовательно, репродуктивной ценности. Красота не поверхностна. Она говорит о внутренних репродуктивных способностях организма. Хотя современные технологии репродуктивной медицины помогают женщинам сохранять способность к деторождению в более зрелом возрасте, чем это было возможно в прошлом, мужские предпочтения в отношении женщин с явными признаками репродуктивных способностей продолжают действовать, хотя они и возникли очень давно в мире, который больше не существует.

Однако стандарты привлекательности вовсе не искусственны — они отражают признаки молодости и здоровья, а следовательно, репродуктивной ценности. Красота не поверхностна. Она говорит о внутренних репродуктивных способностях организма. Хотя современные технологии репродуктивной медицины помогают женщинам сохранять способность к деторождению в более зрелом возрасте, чем это было возможно в прошлом, мужские предпочтения в отношении женщин с явными признаками репродуктивных способностей продолжают действовать, хотя они и возникли очень давно в мире, который больше не существует.

Впрочем, культура, экономические условия и технологический прогресс играют важную роль в оценке мужчинами девственности. Там, где женщины менее зависимы от мужчин экономически, как в Швеции, на сексуальную свободу смотрят сквозь пальцы, и мужчины не требуют девственности от потенциальных жен. Эти перемены отражают чувствительность некоторых мужских предпочтений к особенностям культуры и контекста.

Несмотря на культурные вариации, в долговременных отношениях сексуальная верность для мужчин является важнейшим условием. Хотя многие западные мужчины не могут требовать от партнерш девственности, они обычно настаивают на верности. Методы контроля рождаемости, возможно, и сделали это предпочтение неважным с точки зрения гарантии отцовства, но тем не менее оно сохраняется. Мужчины не перестают требовать верности от жен просто потому, что те принимают противозачаточные таблетки. Это постоянство указывает на важность нашей эволюционной сексуальной психологии — психологии, которая возникла с ориентацией на важнейшие условия первобытного мира, но продолжает сохранять свою власть и в нынешнем мире сексуальных отношений.

Влияние СМИ на стандарты красоты

Рекламщики широко эксплуатируют привлекательность красивых молодых женщин. Некоторые даже утверждают, что именно СМИ и Мэдисон-авеню формируют единый стандарт красоты, к которому все должны стремиться. Считается, что реклама внушает неестественные, идеализированные компьютерные образы красоты и заставляет людей стремиться к ним. Такая интерпретация, возможно, в какой-то мере и верна, особенно когда нам демонстрируют неестественно худеньких моделей, однако в то же время она как минимум отчасти ошибочна. Стандарты красоты не являются чем-то необоснованным — это надежные признаки репродуктивной ценности. Рекламщикам ни к чему навязывать нам какие-то стандарты красоты, они просто используют все, что помогает продавать товары. Они сажают юную девушку с чистой кожей и правильными чертами лица на капот автомобиля последней модели или показывают, как несколько привлекательных женщин с любовью смотрят на мужчину, пьющего пиво известной марки, поскольку эти образы включают определенные психологические механизмы мужчин и таким образом помогают продавать машины или пиво, а не потому, что рекламщикам хочется установить определённый стандарт красоты.

Считается, что реклама внушает неестественные, идеализированные компьютерные образы красоты и заставляет людей стремиться к ним. Такая интерпретация, возможно, в какой-то мере и верна, особенно когда нам демонстрируют неестественно худеньких моделей, однако в то же время она как минимум отчасти ошибочна. Стандарты красоты не являются чем-то необоснованным — это надежные признаки репродуктивной ценности. Рекламщикам ни к чему навязывать нам какие-то стандарты красоты, они просто используют все, что помогает продавать товары. Они сажают юную девушку с чистой кожей и правильными чертами лица на капот автомобиля последней модели или показывают, как несколько привлекательных женщин с любовью смотрят на мужчину, пьющего пиво известной марки, поскольку эти образы включают определенные психологические механизмы мужчин и таким образом помогают продавать машины или пиво, а не потому, что рекламщикам хочется установить определённый стандарт красоты.

Тем не менее у медиаобразов, воздействию которых мы ежедневно подвергаемся, есть потенциально опасные последствия. В одном исследовании группам мужчин показывали фотографии очень привлекательных женщин и женщин средней привлекательности, а затем просили оценить преданность своим романтическим партнершам. Мужчины, которые рассматривали фотографии красивых женщин, находили своих партнерш менее привлекательными, чем мужчины, которые рассматривали фотографии женщин средней привлекательности. Еще важнее то, что мужчины из первой группы ниже оценивали свою преданность, удовлетворенность, серьезность и близость отношений со своими реальными партнершами. Аналогичные результаты были получены в другом исследовании, где мужчины рассматривали журнальные фото обнаженных моделей: они также ниже оценивали привязанность к своим партнершам.

В одном исследовании группам мужчин показывали фотографии очень привлекательных женщин и женщин средней привлекательности, а затем просили оценить преданность своим романтическим партнершам. Мужчины, которые рассматривали фотографии красивых женщин, находили своих партнерш менее привлекательными, чем мужчины, которые рассматривали фотографии женщин средней привлекательности. Еще важнее то, что мужчины из первой группы ниже оценивали свою преданность, удовлетворенность, серьезность и близость отношений со своими реальными партнершами. Аналогичные результаты были получены в другом исследовании, где мужчины рассматривали журнальные фото обнаженных моделей: они также ниже оценивали привязанность к своим партнершам.

Причина таких изменений отношения заключается в нереалистичном характере данных изображений. Нескольких привлекательных женщин, снимающихся в рекламе, выбирают из тысяч претенденток. Во многих случаях делаются тысячи фотографий выбранной модели. Известно, например, что в журнале Playboy делают около 6000 снимков девушки, появляющейся на развороте. Из этих тысяч фотографий лишь несколько отбирают для разворота и рекламы. А потом эти снимки обрабатывают в фоторедакторе. В результате мужчины видят не то, что есть в действительности, а искусно обработанные изображения самых привлекательных женщин в самых привлекательных позах на самом привлекательном фоне. Сравните эти фотографии с тем, на что смотрел первобытный мужчина, живший в группе не более чем из 150 человек. Вряд ли в таких условиях ему удавалось видеть сотни или хотя бы десятки привлекательных женщин. Однако, будь у него доступ к множеству привлекательных фертильных женщин, он вполне мог бы захотеть сменить партнершу и его преданность реальной спутнице снизилась бы.

Из этих тысяч фотографий лишь несколько отбирают для разворота и рекламы. А потом эти снимки обрабатывают в фоторедакторе. В результате мужчины видят не то, что есть в действительности, а искусно обработанные изображения самых привлекательных женщин в самых привлекательных позах на самом привлекательном фоне. Сравните эти фотографии с тем, на что смотрел первобытный мужчина, живший в группе не более чем из 150 человек. Вряд ли в таких условиях ему удавалось видеть сотни или хотя бы десятки привлекательных женщин. Однако, будь у него доступ к множеству привлекательных фертильных женщин, он вполне мог бы захотеть сменить партнершу и его преданность реальной спутнице снизилась бы.

У нас те же самые механизмы оценки, которые выработались в древние времена у наших предков. Однако сегодня на эти психологические адаптации воздействуют десятки образов привлекательных женщин, с которыми мужчины ежедневно сталкиваются в нашей визуально насыщенной среде — в интернете, журналах, на рекламных плакатах, телевидении и в кино. Эти образы не соответствуют реальным женщинам в реальной социальной среде. Они, можно сказать, лишают нас адаптаций, выработанных для иных условий поиска партнера. Иногда они способны приносить несчастье, разрушая существующие реальные отношения. Доступ к тысячам объявлений потенциальных партнеров на таких интернет-ресурсах и приложениях, как Tinder, Match.com и OKCupid, может сбивать с толку и заставлять думать, что можно найти кого-то получше, стоит только просмотреть достаточно много вариантов.

Эти образы не соответствуют реальным женщинам в реальной социальной среде. Они, можно сказать, лишают нас адаптаций, выработанных для иных условий поиска партнера. Иногда они способны приносить несчастье, разрушая существующие реальные отношения. Доступ к тысячам объявлений потенциальных партнеров на таких интернет-ресурсах и приложениях, как Tinder, Match.com и OKCupid, может сбивать с толку и заставлять думать, что можно найти кого-то получше, стоит только просмотреть достаточно много вариантов.

Под влиянием этих образов мужчины теряют удовлетворенность и преданность существующим партнершам. Они потенциально вредны и для женщин, так как вызывают бесконтрольное и нездоровое состязание за идеальную фигуру, которая якобы привлекательна для мужчин, но на деле далека от того, что предпочитает большинство. Беспрецедентный уровень распространения расстройств пищевого поведения, таких как нервно-психическая анорексия, а также расцвет пластической хирургии, например абдоминопластика и увеличение груди, в определенной мере зависят от этих медиаобразов. Некоторые женщины идут на немыслимые жертвы, чтобы стать тем, что они считают мужским идеалом. Но к таким последствиям при- водит вовсе не создание каких-то новых стандартов красоты. Стандарты женской красоты у мужчин существуют давно, так же как и механизмы соперничества за партнера у женщин, а СМИ просто эксплуатируют их с невиданным и нездоровым размахом.

Некоторые женщины идут на немыслимые жертвы, чтобы стать тем, что они считают мужским идеалом. Но к таким последствиям при- водит вовсе не создание каких-то новых стандартов красоты. Стандарты женской красоты у мужчин существуют давно, так же как и механизмы соперничества за партнера у женщин, а СМИ просто эксплуатируют их с невиданным и нездоровым размахом.

Какую бы роль ни играла красота тела и лица в мужских предпочтениях, эти качества помогают решить только один набор адаптивных задач, стоящих перед мужчинами, — поиск способных к деторождению женщин и вступление с ними в сексуальный контакт. Однако выбор репродуктивно ценной партнерши не гарантирует, что эта ценность будет принадлежать только одному муж- чине. Следующая важнейшая адаптивная задача — гарантия отцовства.

Список игр на ПК про эволюцию

Sid Meiers Сivilization 4: Beyond the Sword

Год выхода: 2007

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Civilization IV: Beyond the Sword является вторым дополнением культовой игры Civilization IV, где появилось много незначительных, но приятных изменений. По традиции новации не затронули главных моментов игры, а сама она сделана на высоком уровне…

По традиции новации не затронули главных моментов игры, а сама она сделана на высоком уровне…

85 /100

Sid Meiers Civilization 4

Год выхода: 2005

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Sid Meiers Civilization IV очередная история в цепочке пошаговых стратегий от Сида Мейера. От вас требуется развить собственную империю, преодолев дорогу длиною в несколько веков…

83 /100

Sid Meiers Civilization 4: Warlords

Год выхода: 2006

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Civilization IV: Warlords это первое дополнение культовой игры Civilization IV. В игру было добавлено много новшеств. Добавлены шесть цивилизаций со своими новыми и неповторимыми юнитами и постройками…

82 /100

Sid Meiers Alpha Centauri

Год выхода: 1999

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Фантастическое будущее предстает перед нами. Люди Земли создают необычайно большой космическая корабль. Специально отобранная команда уже на пути к новой планете. Это шанс сохранить человечество от исчезновения…

Люди Земли создают необычайно большой космическая корабль. Специально отобранная команда уже на пути к новой планете. Это шанс сохранить человечество от исчезновения…

81 /100

Age of Empires 2

Год выхода: 1999

Платформы: MacOS, PlayStation 2, на ПК

Системные требования: низкие

Жанр: строительство, стратегия

Age of Empires II: The Age of Kings это очередная часть полюбившейся всем Age of Empires. Действия игры простираются на многие тысячи лет. Для управления доступны 13 наций, с которыми вы сможете пройти все эпохи развития…

81 /100

Sid Meiers Civilization

Год выхода: 1991

Платформы: MacOS, на ПК

Системные требования: неизвестно

Жанр: стратегия

Civilization — это известная серия пошаговых стратегий. В начале 90-х американец Сид Мейер создал первую игру этой серии, и Sid Meiers Civilization завоевала популярность среди геймеров…

79 /100

Sid Meiers Civilization 3

Год выхода: 2001

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Sid Meiers Civilization III это TBS компьютерная игра, разработанная компанией Firaxis Games, и являющаяся сиквелом ко второй части серии игр от Sid Meier. В новой версии Civilization III Вы сможете управлять избранной Вами нацией, а также преодолеете тяжелый путь от зарождения цивилизации и до ее золотого века…

В новой версии Civilization III Вы сможете управлять избранной Вами нацией, а также преодолеете тяжелый путь от зарождения цивилизации и до ее золотого века…

79 /100

Sid Meiers Civilization 5

Год выхода: 2010

Платформы: MacOS, на ПК

Системные требования: средние

Жанр: стратегия

В игре Sid Meiers Civilization V разработчиками воплощено много новшеств. Полностью изменилась методика ведения боевых действий, углубилась система дипломатических связей…

79 /100

Sid Meiers Civilization 3: Conquests

Год выхода: 2002

Платформы: на ПК

Системные требования: низкие

Жанр: стратегия

По сути это второе дополнение к Civilization III в которое включен его предыдущий аддон — Play the World. Название связано с историческими событиями человечества разных эпох, которым посвящены новые девять сюжетов…

78 /100

Sid Meiers Civilization 3: Play the World

Год выхода: 2003

Платформы: на ПК

Системные требования: низкие

Жанр: стратегия

Для популярной глобальной стратегии Civilization III Сида Майера первым дополнением стала игра Civilization III: Play the World. В ней впервые открылись перед игроками новые возможности сражения с настоящими живыми соперниками по сети, для того, чтобы определить самого лучшего мирового правителя…

В ней впервые открылись перед игроками новые возможности сражения с настоящими живыми соперниками по сети, для того, чтобы определить самого лучшего мирового правителя…

78 /100

Sid Meiers Civilization 2

Год выхода: 1996

Платформы: MacOS, PlayStation, на ПК

Системные требования: низкие

Жанр: стратегия

Такая игра, как Sid Meiers Civilization II – это долгожданное продолжение первой части игры, заслуживающее безраздельного внимания. Если сравнивать с предыдущей частью, то в Civilization 2 существенно улучшилась графика, были добавлены юниты, включены новые технологии, цивилизации и части света…

77 /100

Sid Meiers Civilization 4: Colonization

Год выхода: 2008

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: стратегия

Civilization IV: Colonization — это третий ремейк очень популярной и любимой многими игры Colonization. Вы становитесь главой одной из четырех наций Европы. Вам необходимо создать очень сильную и независимую колонию, которая затем объявит себя новым могущественным государством…

Вам необходимо создать очень сильную и независимую колонию, которая затем объявит себя новым могущественным государством…

75 /100

Age of Empires 3

Год выхода: 2005

Платформы: MacOS, на ПК

Системные требования: низкие

Жанр: строительство, стратегия

Age of Empires III — это свежая версия знаменитой серии Age of Empires. Здесь предлагается руководить могущественной европейской державой. Можно встать у руля одной из 8 стран: Турции, Германии, Франции, Португалии, Англии, Голландии, России, Испании…

75 /100

Plague Inc

Год выхода: 2015

Платформы: на ПК

Системные требования: низкие

Жанр: головоломка, тайм менеджмент

Plague Inc: Evolved очень своеобразная игра жанра стратегия, симулятор. Выглядит как довольно подробная карта Земли. Выступая в роли возбудителя эпидемии игрок должен уничтожить население планеты…

75 /100

Age of Empires III: Definitive Edition

Год выхода: 2020

Платформы: на ПК

Системные требования: высокие

Жанр: градостроительный симулятор, стратегия

Age of Empires III: Definitive Edition — это стратегическая компьютерная игра в реальном времени, разработанная студиями Tantalus Media и Forgotten Empires и изданная Xbox Game Studios. ..

..

75 /100

World of Tanks

Бесплатный

сервер

Год выхода: 2011

Платформы: на ПК, Xbox 360, Xbox One

Системные требования: средние

Жанр: боевик, шутер, экшен, симулятор

World of Tanks — командная тактическая ММО-игра, основным боевым инструментом и средством передвижения которой является танк. Для выбора доступно более 150 бронированных крошек с американских, немецких и советских танкостроительных заводов…

86 /100

Страницы: 1 2 3

Стратегия vs. бизнес-модель: эволюция и дифференциация | Орехова

1. Ансофф И. Стратегический менеджмент. Классическое издание. — СПб.: Питер, 2009.

2. Березной А.В. Инновационные бизнес-модели в конкурентной стратегии крупных корпораций // Вопросы экономики. — 2014. — No 9. — С. 65–81.

3. Гурков И. Б. Стратегический менеджмент организации. 2-е изд. — М.: ТЕИС, 2004.

4. Джонсон Дж., Хафф А.С. Повседневная инновация/повседневная стратегия // Хэмел Г. , Прахалад К., Томас Г., О`Нил Д. Стратегическая гибкость / пер. с англ. — СПб.: Питер, 2005.

, Прахалад К., Томас Г., О`Нил Д. Стратегическая гибкость / пер. с англ. — СПб.: Питер, 2005.

5. Катькало В. С. Исходные концепции стратегического управления и их современная оценка // РЖМ. — 2003. — No 1. — С. 7–30.

6. Катькало В.С. Эволюция теории стратегического управления. — СПб.: Изд-во «Высшая школа менеджмента», 2006.

7. Климанов Д. Е., Третьяк О. А. Бизнес-модели: основные направления исследований и поиски содержательного фундамента концепции // Российский журнал менеджмента. — 2014. — Т. 12. — No 3. — С. 107–130.

8. Котельников В. Ю. Новые бизнес-модели для новой эпохи быстрых перемен, движимых инновациями. — М.: Эксмо, 2007.

9. Лафта Дж. К. Эффективность менеджмента организации. — М.: Русская Де- ловая Литература, 1999.

10. Медведев А. Г. Международный менеджмент: стратегические решения в многонациональных компаниях: учебник. — СПб.: Изд-во «Высшая школа менеджмента», 2014.

11. Орехова С. В. Промышленные предприятия: электронная vs. традиционная бизнес-модель // Terra Economicus. — 2018a. — Т. 16. — No 4. — С. 77–94.

— 2018a. — Т. 16. — No 4. — С. 77–94.

12. Плахин А. Е. Методология адаптивного управления промышленной парковой структурой на основе стейкхолдерского подхода // Вестник Воронежского государственного университета инженерных технологий. — 2018. — No 80(4). — С. 371–377.

13. Пономарев А. Т. Проблемно-ориентированная методология стратегического целеполагания как условие прогрессивного развития общества: социально-экономическое развитие (ч. 2) // Вопросы безопасности. — 2017. — No 4. — С. 1-12.

14. Прахалад К., Хамел Г. Ключевая компетенция корпорации // Вестник Санкт-Петербургского университета. Сер. 8. — 2003. — Вып. 3. — No 24. — С. 23–46.

15. Романова О. А. Эволюция институтов реализации современной промышленной политики // Управленец. — 2019. — Т. 10. — No 3. — С. 14–24.

16. Силин Я.П., Анимица Е.Г. Контуры формирования цифровой экономики в России // Известия Уральского государственного экономического университета. — 2018. — Т. 19. — No 3. — С. 18−25.

17. Стрекалова Н. Д. Концепция бизнес-модели: методология системного анализа // Известия Российского государственного педагогического университета им. А. И. Герцена. — 2009. — No 92. — С. 95–105.

Стрекалова Н. Д. Концепция бизнес-модели: методология системного анализа // Известия Российского государственного педагогического университета им. А. И. Герцена. — 2009. — No 92. — С. 95–105.

18. Третьяк О.А., Климанов Д.Е. Новый подход к анализу бизнес-моделей // Российский журнал менеджмента. — 2016. — Т. 14. — No 1. — С. 115–130.

19. Фролова Л. В., Кравченко Е. С. Формирование бизнес-модели предприятия. — К.: Центр учебной литературы, 2012.

20. Чесбро Г. Открытые бизнес-модели. IP-менеджмент. — М.: Поколение, 2008.

21. Чугумбаев Р. Р. Эталонное управление на основе бизнес-модели совершенства // Учет. Анализ. Аудит. — 2016. — No 1. — С. 58–34.

22. Шерешева М. Ю. Формы сетевого взаимодействия компаний. — М.: ГУ ВШЭ, 2010.

23. Abell D.F. Managing with Dual Strategies: Mastering the Present; Preempting the Future. — N. Y.: Free Press, 1999.

24. Abdelkafi N., Täuscher K. Business models for sustainability from a system dynamics perspective // Organization & Environment. — 2016. — Vol. 29. — P. 74–96.

— 2016. — Vol. 29. — P. 74–96.

25. Amit R., Zott C. Value creation in e-business // Strategic Management Journal. — 2001. — Vol. 22. — P. 493–520.

26. Andrews K. R. The Concept of Corporate Strategy. — Homewood, IL: Dow Jounes-Irwin, 1971.

27. Ansoff H.I. Corporate Strategy: An Analytical Approach to Business Policy for Growth and Expansion. — N. Y.: McGraw-Hill Book Co., 1965.

28. Baden-Fuller C., Giudici A., Haefliger S., Morgan M. S. Ideal types, values, profits and technologies. — L.: London School of Economics, 2015.

29. Baden-Fuller C., Haefliger S. Business models and technological innovation // Long Range Planning. — 2013. — Vol. 46. — P. 419–426.

30. Barlett C., Ghoshal S. Managing Across Borders: The Transnational Corporation. — Cambridge, MA: Harvard Business Review Press, 1989.

31. Bocken N. M. P., Short S., Rana P., Evans S. A literature and practice review to develop sustainable business model archetypes // Journal of Cleaner Production. — 2014. — Vol. 65. — P. 42–56.

— 2014. — Vol. 65. — P. 42–56.

32. Burney J.B. Firm recourses and sustained competitive advantage // Journal of Management. — 1991. — Vol. 17. — No. 1. — P. 99–120.

33. Casadesus-Masanell R., Ricart J. From strategy to business models and to tactics // Long Range Planning. — 2010. — Vol. 43. — P. 195–215.

34. Chandler A. D., Jr. Strategy and Structure: Chapters in the History of American Enterprise. — Cambridge, MA: MIT Press, 1962.

35. Chesbrough H. Business model innovation: It’s not just about technology anymore // Strategy & Leadership. — 2007. — Vol. 35. — No. 6. — P. 12–17.

36. Chesbrough H., Minin A. di, Piccaluga A. Business model innovation path. In: Cinquini L., Minin A. di, Varaldo R. (eds). New business models and value creation: A service science perspective. — Milano: Springer-Verlag, 2013.

37. Chesbrough H., Rosenbloom R. The role of the business model in capturing value from innovation: Evidence from Xerox Corporation’s technology spin-off companies // Industrial and Corporate Change. — 2002. — Vol. 11. — P. 529–555.

— 2002. — Vol. 11. — P. 529–555.

38. Demil B., Lecocq X. Business model evolution: In search of dynamic consistency // Long Range Planning. — 2010. — Vol. 43. — No. 2. — Р. 227–246.

39. Doleski O. Integrated business model. Applying the St. Gallen management concept to business models. — Wiesbaden: Springer Gabler, 2015.

40. Dubosson-Torbay M., Osterwalder A., Pigneur Y. E-business model design, classification, and measurements // Thunderbird International Business Review. — 2002. — Vol. 44. — No. 1. — P. 5–23.

41. Foss N. J., Saebi T. Business Model Innovation: The Organizational Dimension. Oxford Scholarship Online: April 2015.

42. Foss N. J., Saebi T. Fifteen years of research on business model innovation: How far have we come, and where should we go? // Journal of Management. — 2017. — Vol. 43. — No. 1. — P. 200–227.

43. Hamel G. Leading the revolution. — Boston: Harvard Business School Press, 2000.

44. Hawkins R. The phantom of the marketplace: Searching for new e-commerce business models // Euro CPR 2002. Barcelona, March, 24–26, 2002.

Barcelona, March, 24–26, 2002.

45. Hedman J., Kalling T. The business model concept: Theoretical underpinnings and empirical illustrations // European Journal of Information Systems. — 2003. — Vol. 12. — P. 49–59.

46. Higgins J. M. Organization Policy and Strategic Management: Text and Cases. — Chicago: The Drydent Press, 1983.

47. Hofer C. W., Schendel D. Strategy Formulation: Analytical Concepts. — St. Paul, MN: West Publishing, 1978.

48. Hoskisson R. E., Hitt M. A., Wan W. P., Yiu D. Theory and Research in Strategic Management: Swings of the Pendulum // Journal of Management. — 1999. — Vol. 25. — No. 3. — Р. 417–456.

49. Johnson M., Christensen C., Kagermann H. Reinventing tour business model // Harvard Business Review. — 2008. — Vol. 86. — No. 12. — P. 50–59.

50. Keen P., Qureshi S. Organizational Transformation Through Business Models: A Framework for Business Model Design // System Sciences, HICSS’06. Proceedings of the 39th Annual Hawaii International Conference, 2006, 8: 206b–206b.

51. Lecoq X., Demil B., Warnier V. Le Business Model, un Outil d’Analyse Strate ́gique // L’Expansion Management Review. — 2006. — Vol. 123. — P. 50–59.

52. Magretta J. Why business models matter? // Harvard Business Review. — 2002. — Vol. 80. — No. 5. — P. 86–92.

53. Mahadevan B. Business models for Internet-based E-Commerce. An Anatomy // California Management Review. — 2000. — Vol. 42. — No. 4. — P. 55–69.

54. McGrath R.G. Business Models: A Discovery Driven Approach // Long Range Planning. — 2010. — Vol. 43. — P. 247–261.

55. Mintzberg H. 1994. The Rise and Fall of Strategic Planning. — N. Y.: Free press. P. 221–321.

56. Mintzberg H. Patterns in strategy formulation // Management Science. — 1978. — Vol. 24. — No. 9. — P. 934–948.

57. Morris M., Schindehutte M., Allen J. The entrepreneur’s business model: Toward a unified perspective // Journal of Business Research. — 2005. — Vol. 58. — P. 726–735.

58. Onetti A., Zucchella A., Jones M. V., McDougall-Covin P.P. Internationalization, innovation and entrepreneurship: Business models for new technology-based firms // Journal of Management and Governance. — 2012. — Vol. 16. — P. 337- 368.

V., McDougall-Covin P.P. Internationalization, innovation and entrepreneurship: Business models for new technology-based firms // Journal of Management and Governance. — 2012. — Vol. 16. — P. 337- 368.

59. Osterwalder A., Pigneur Y. Business model generation: a handbook for visionaries, game changers, and challengers. — New Jersey: Wiley, 2010.

60. Osterwalder A., Pigneur Y., Tucci C. Clarifying business models: Origins, present, and future of the concept // Communications of the Association for Information Systems. — 2005. — Vol. 16. — P. 1–25.

61. Pearce J.A., Robinson R.B. Jr. Strategic Management: Strategy Formulation and Implementation. 2d ed. — Homewood, Ill.: Richard D. Irwin, 1985.

62. Peric M., Durkin J., Vitezic V. The constructs of a business model redefined: A half- century journey // SAGE Open. — 2017. — Vol. 7. — No. 3. — P. 1–13.

63. Peters T. Liberation Management. — N. Y.: Knopf, 1992.

64. Porter M. E. What Is Strategy? // Harvard Business Review. — 1996. — Vol. 74. — No. 6. — P. 61–78.

— 1996. — Vol. 74. — No. 6. — P. 61–78.

65. Richardson J. The business model: an integrative framework for strategy execution // Strategic Change. — 2008. — Vol. 17. — P. 133–144.

66. Roome N., Louche C. Journeying toward business models for sustainability: A conceptual model found inside the black box of organizational transformation // Organization & Environment. — 2016. — Vol. 29. — P. 11–35.

67. Rumelt R.P. Diversification strategy and profitability // Strategic Management Journal. — 1982. — Vol. 3. — No. 4. — P. 359–369.

68. Runfola A., Rosati M., Guercini S. New business models in online hotel distribution: Emerging private sales versus leading IDS // Service Business. — 2013. — No. 7. — P. 183–205.

69. Schendel D.E., Hatten K.J. Business policy or strategic management: A broader view for an emerging discipline // Academy of Management Proceedings. — 1972. — No. 1. — P. 99–102.

70. Shafer S., Smith H., Linder J. The power of business models // Business Horizons. — 2005. — Vol. 48. — P. 199–207.

— 2005. — Vol. 48. — P. 199–207.

71. Solaimani S., Bouwman H. A framework for the alignment of business model and business processes // Business Process Management Journal. — 2012. — Vol. 18. — No. 4. — P. 655–679.

72. Stewart D., Zhao Q. Internet marketing, business models and public policy // Journal of Public Policy and Marketing. — 2000. — Vol. 19. — P. 287–296.

73. Taran Y., Boer H., Lindgren P. A Business Model Innovation Typology // Decision Sciences. — 2015. — Vol. 46. — No. 2. — P. 301–331.

74. Teece D. Business models, business strategy and innovation // Long Range Planning. — 2010. — Vol. 43. — P. 172–194.

75. Thompson A.A., Strickland A.J. Grafting & Implementing Strategy. — IRWIN Press, 1995.

76. Tikkanen H., Lamberg J.-A., Parvinen P., Kallunki J.-P. Managerial cognition, action and the business model of the firm // Management Decision. — 2005. — Vol. 43. — No. 6. — P. 789–809.

77. Timmers P. Business models for electronic markets // Electronic Markets. — 1998. — Vol. 8. — No. 2. — Р. 3–8.

— 1998. — Vol. 8. — No. 2. — Р. 3–8.

78. Wernerfelt B. A resource-based view of the firm // Strategic Management Journal. — 1984. — Vol. 2. — No. 2. — Р. 171–180.

79. Williamson O. E. Markets and Hierarchies. N. Y.: Free Press, 1975.

80. Wirtz B. Electronic Business. Wiesbaden: Gabler, 2000.

81. Wirtz B., Pistoia A., Ullrich S., Göttel V. Business models: Origin, development and future research perspectives // Long Range Planning. — 2016. — Vol. 49. — No. 1. — P. 36–54.

82. Zollo M., Minoja M., Coda V. Toward an integrated theory of strategy // Strategic Management Journal. — 2017. — Vol. 39. — P. 1753–1778.

83. Zott C., Amit R. The fit between product market strategy and business model: implications for firm performance // Strategic Management Journal. — 2008. — Vol. 29. — No. 1. — P. 1-26.

84. Zott C., Amit R., Massa L. The Business Model: Recent Developments and Future Research // Journal of Management. — 2011. — Vol. 37. — No. 4. — P. 1019–1042.

Стратегии эволюции — Scholarpedia

| Ханс-Георг Бейер (2007), Scholarpedia, 2 (8): 1965. | doi:10.4249/scholarpedia.1965 | редакция #193589 [ссылка/цитировать эту статью] |

Постпубликационная деятельность

Куратор: Ханс-Георг Бейер

Авторы:

0,29 —

Николаус Хансен

0,29 —

Ижикевич Евгений Михайлович

0,14 —

Роберт Вюнше

0,14 —

Бенджамин Броннер

Доктор Ханс-Георг Бейер, Форарльбергский университет прикладных наук

Стратегии эволюции (ЭС) являются подклассом вдохновленных природой

методы прямого поиска (и оптимизации), принадлежащие к классу

Эволюционные алгоритмы (ЭА), которые используют мутацию, рекомбинацию,

отбор, применяемый к популяции особей, содержащих

возможные решения, чтобы итеративно развиваться все лучше и лучше

решения. * = \mathrm{argopt}_{{\mathbf{y} \in \mathcal{Y}}} \, f(\mathbf{y}),

\]

функция \(f(\mathbf{y})\), которую необходимо оптимизировать, также упоминается

как целевая (или целевая) функция, может быть представлена в математическом

форму, с помощью моделирования или даже с точки зрения измерений, полученных из

реальные объекты. ES также может быть применен к набору целевых функций

в контексте многоцелевой оптимизации

(см. также Многокритериальные эволюционные алгоритмы и Многокритериальный поиск).

* = \mathrm{argopt}_{{\mathbf{y} \in \mathcal{Y}}} \, f(\mathbf{y}),

\]

функция \(f(\mathbf{y})\), которую необходимо оптимизировать, также упоминается

как целевая (или целевая) функция, может быть представлена в математическом

форму, с помощью моделирования или даже с точки зрения измерений, полученных из

реальные объекты. ES также может быть применен к набору целевых функций

в контексте многоцелевой оптимизации

(см. также Многокритериальные эволюционные алгоритмы и Многокритериальный поиск).

Содержимое

|

Канонические версии ES

Канонические версии ES обозначаются

\[

(\mu/\rho, \lambda)\mbox{-ES} \quad \mbox{and} \quad

(\mu/\rho + \lambda)\mbox{-ES},

\]

соответственно. Здесь \(\mu\) обозначает количество родителей,

\(\rho \leq \mu\) число смешивания (т. е. количество родителей

участвует в рождении потомства), и \(\лямбда\)

количество потомства. Родители детерминистически выбраны

(т. е. детерминированный отбор выживших) из

(много) набор потомков, обозначаемый как выбор запятой (\( \mu < \lambda \) должно выполняться), или как родители, так и потомство,

называется плюс-выбор .

Выбор основан на рейтинге пригодности людей.

\(F(\mathbf{y})\), взяв \(\mu \) лучших особей

(также называется усеченным выбором). В общем,

\[

\mbox{ES индивидуальный} \quad \mathbf{a} := (\mathbf{y}, \mathbf{s}, F(\mathbf{y}))

\]

содержит вектор параметров объекта \(\mathbf{y} \in \mathcal{Y}\) для оптимизации,

набор параметров стратегии \(\mathbf{s}\ ,\), необходимых особенно в

самоадаптирующиеся ЭС и наблюдаемая приспособленность человека \(F(\mathbf{y})\)

эквивалентна целевой функции \(f(\mathbf{y})\ ,\), т. е.

\(F(\mathbf{y}) \equiv f(\mathbf{y})\) в простейшем случае.

Здесь \(\mu\) обозначает количество родителей,

\(\rho \leq \mu\) число смешивания (т. е. количество родителей

участвует в рождении потомства), и \(\лямбда\)

количество потомства. Родители детерминистически выбраны

(т. е. детерминированный отбор выживших) из

(много) набор потомков, обозначаемый как выбор запятой (\( \mu < \lambda \) должно выполняться), или как родители, так и потомство,

называется плюс-выбор .

Выбор основан на рейтинге пригодности людей.

\(F(\mathbf{y})\), взяв \(\mu \) лучших особей

(также называется усеченным выбором). В общем,

\[

\mbox{ES индивидуальный} \quad \mathbf{a} := (\mathbf{y}, \mathbf{s}, F(\mathbf{y}))

\]

содержит вектор параметров объекта \(\mathbf{y} \in \mathcal{Y}\) для оптимизации,

набор параметров стратегии \(\mathbf{s}\ ,\), необходимых особенно в

самоадаптирующиеся ЭС и наблюдаемая приспособленность человека \(F(\mathbf{y})\)

эквивалентна целевой функции \(f(\mathbf{y})\ ,\), т. е.

\(F(\mathbf{y}) \equiv f(\mathbf{y})\) в простейшем случае. Различие между \(F(\mathbf{y})\) и \(f(\mathbf{y})\)

необходимо, так как \(F(\mathbf{y})\) может быть результатом локального

оператор поиска, который применяется к \(f(\mathbf{y})\)-функции

быть оптимизированным, или даже

может быть результатом другого ES (см. Мета-ES ниже).

Кроме того, наблюдаемое \(F(\mathbf{y})\) может быть результатом

зашумленный \(f(\mathbf{y})\)-процесс оценки.

Различие между \(F(\mathbf{y})\) и \(f(\mathbf{y})\)

необходимо, так как \(F(\mathbf{y})\) может быть результатом локального

оператор поиска, который применяется к \(f(\mathbf{y})\)-функции

быть оптимизированным, или даже

может быть результатом другого ES (см. Мета-ES ниже).

Кроме того, наблюдаемое \(F(\mathbf{y})\) может быть результатом

зашумленный \(f(\mathbf{y})\)-процесс оценки.

Концептуальный алгоритм \((\mu/\rho \; \stackrel{+}{,} \;\lambda)\)-ES приведен ниже:

\((\mu/\rho \; \stackrel{+}{,} \; \lambda)\)-Самоадаптация-Эволюция-Стратегия

- Инициализировать родительскую популяцию \(\mathbf{P}_\mu = \{ \mathbf{a}_1, \ldots, \mathbf{a}_{\mu} \}\ .\)

- Создание \(\lambda\) потомков \(\tilde{\mathbf{a}}\), формирующих популяцию потомков \(\tilde{\mathbf{P}}_\lambda = \{ \tilde{\mathbf{ a}}_1, \ldots, \tilde{\mathbf{a}}_\lambda\}\), где каждое потомство \(\tilde{\mathbf{a}}\) генерируется:

- Выбрать (случайно) \(\rho\) родителей из \(\mathbf{P}_\mu\) (если \(\rho = \mu\) вместо этого взять всех родительских особей).

- Рекомбинация \(\rho\) выбранных родителей \(\mathbf{a}\) для формирования рекомбинантной особи \(\mathbf{r}\ .\)

- Мутировать набор параметров стратегии \(\mathbf{s}\) рекомбинантного \(\mathbf{r}\ .\)

- Измените набор целевых параметров \(\mathbf{y}\) рекомбинантного \(\mathbf{r}\), используя набор параметров измененной стратегии для управления статистическими свойствами мутации параметров объекта.

- Выбрать (случайно) \(\rho\) родителей из \(\mathbf{P}_\mu\) (если \(\rho = \mu\) вместо этого взять всех родительских особей).

- Выберите новую родительскую популяцию (используя детерминированный выбор усечения) из

- популяция потомков \(\tilde{\mathbf{P}}_\lambda\) (обозначается как запятая -отбор, обычно обозначается как «\((\mu,\lambda)\)-отбор «), или же

- потомок \(\tilde{\mathbf{P}}_\lambda\) и родительская \(\mathbf{P}_\mu\) популяция (обозначается как плюс -отбор, обычно обозначается как «\((\mu + \lambda)\)-выбор»)

- Перейти к 2. до критерий завершения выполнен.

В зависимости от области поиска и целевой функции

\(f(\mathbf{y})\ ,\) рекомбинация и/или мутация

параметры стратегии могут встречаться или не встречаться в конкретных реализациях

алгоритм. Например, \((\mu/1 + \lambda)\)-ES,

или, что то же самое, \((\mu + \lambda)\)-ES не использует рекомбинацию.

Он рисует своих новых \(\mu\) родителей для следующего поколения

как от старых \(\mu\) родителей, так и от \(\lambda\)

потомство (полученное от этих родителей), взяв лучшее

\(\mu\) особи

(относительно наблюдаемого \(F(\mathbf{y})\)).

Например, \((\mu/1 + \lambda)\)-ES,

или, что то же самое, \((\mu + \lambda)\)-ES не использует рекомбинацию.

Он рисует своих новых \(\mu\) родителей для следующего поколения

как от старых \(\mu\) родителей, так и от \(\lambda\)

потомство (полученное от этих родителей), взяв лучшее